java架构师面试手册

致各位努力搬砖的程序员

小编本人是双非学校,非计算机专业。通过自学2014进入java编程行业,从刚入职场的惴惴不安,经历了各种困难,一步一步迈入高级开发工程师。从18线小公司,到腾讯,再到美团,目前就职于字节跳动,面试也是收到的offer很多。这其中的困难和曲折就不说了,这里只是把我面试的经验和知识总结分享给大家,希望大家早日拿到满意的offer!

本地运行,或者发布到github的gh-pages

- 全局安装mdbook,gh-pages

cargo install mdbook

cargo install mdbook-wordcount

cargo install mdbook-mermaid

- 本地发布和运行

cd java-interview

mdbook build ## 本地build,生成_book

mdbook serve ## 本地运行查看

版权问题

由于早期个别文章都是从网上找的,没有写引用的出处,如果大家看到了,请指正,小编会第一时间更新出处。

一、为什么准备面试?

1、人是容易遗忘的动物,鱼的记忆只有七秒,而人的记忆只有七天。

2、面试造火箭,进去拧螺丝。是目前大厂普遍的现象,很多知识点平常工作是不会用的,但是你必须会,怎么办呢,自己学习,自己准备,

3、不好的面试结果和评价会被记录下来,至少影响你一年的机会。

4、面试官花时间对你就行面试,你啥都不会,这不是浪费人家时间。

二、如何准备面试

基础知识

- 编程语言的基础

- 集合,多线程,

- 锁,垃圾回收等

- 计算机基础

- 操作系统

- 编译原理

- 网络

- 数据库和缓存

- 分布式理论

项目经验

简历包装

内容框架化

准备设备

- 远程面试的电脑

- 好用的耳机和话筒

- 一个安静的面试环境

三、如何面试

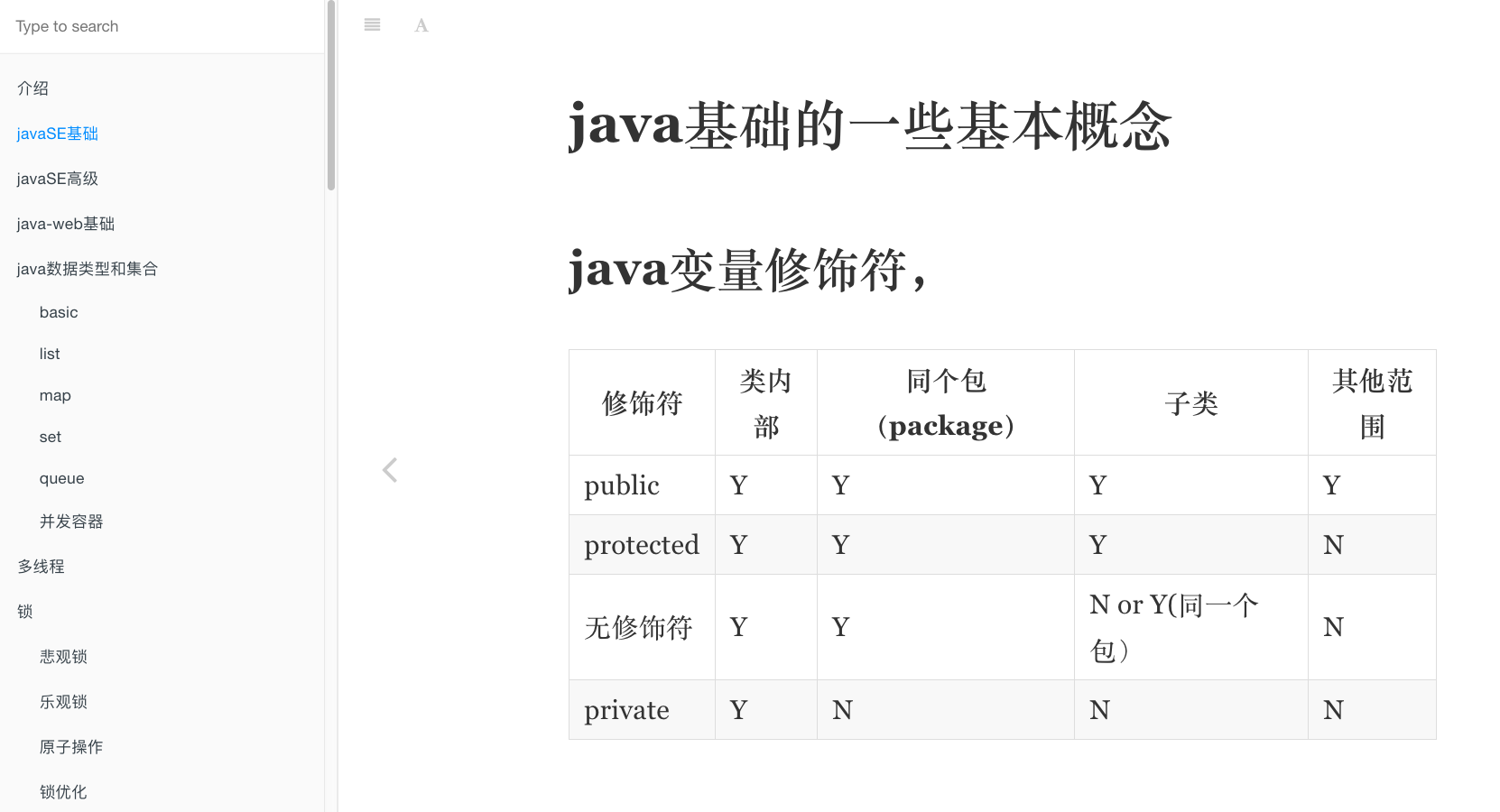

java基础的一些基本概念

1、java变量修饰符,

| 修饰符 | 类内部 | 同个包(package) | 子类 | 其他范围 |

|---|---|---|---|---|

| public | Y | Y | Y | Y |

| protected | Y | Y | Y | N |

| 无修饰符 | Y | Y | N or Y(同一个包) | N |

| private | Y | N | N | N |

2、java的基本类型有哪些?多少位?

boolean(1),byte(8),char(16),short(16), int(32),float(32),double(64),long(64)

3、继承

-

定义:继承是使用已存在的类的定义作为基础建立新类的技术,新类的定义可以增加新的数据或新的功能,也可以用父类的功能,但不能选择性地继承父类。

-

说明:继承所描述的是“is-a”的关系,如果有两个对象A和B,若可以描述为“A是B”,则可以表示A继承B,其中B是被继承者称之为父类或者超类,A是继承者称之为子类或者派生类。实际上继承者是被继承者的特殊化,它除了拥有被继承者的特性外,还拥有自己独有得特性

继承的特征

- 子类拥有父类非private的属性和方法。

- 子类可以拥有自己属性和方法,即子类可以对父类进行扩展。

- 子类可以用自己的方式实现父类的方法

4、封装

- 定义:隐藏对象的属性和实现细节,仅对外公开接口,控制在程序中属性的读和修改的访问级别。

- 封装的目的:增强安全性和简化编程,使用者不必了解具体的实现细节,而只是要通过外部接口,一特定的访问权限来使用类的成员。

- 封装的基本要求是:把所有的属性私有化,对每个属性提供getter和setter方法,如果有一个带参的构造函数的话,那一定要写一个不带参的构造函数。在开发的时候经常要对已经编写的类进行测试,所以在有的时候还有重写toString方法,但这不是必须的。

5、多态

多态就是指程序中定义的引用变量所指向的具体类型和通过该引用变量发出的方法调用在编程时并不确定,而是在程序运行期间才确定,即一个引用变量倒底会指向哪个类的实例对象,该引用变量发出的方法调用到底是哪个类中实现的方法,必须在由程序运行期间才能决定。

6、overwrite overload区别

override(重写,覆盖)

- 方法名、参数、返回值相同

- 子类方法不能缩小父类方法的访问权限

- 子类方法不能抛出比父类方法更多的异常(但子类方法可以不抛出异常)

- 存在于父类和子类之间

- 方法被定义为final不能被重写

overload(重载,过载)

- 参数类型、个数、顺序至少有一个不相同。

- 不能重载只有返回值不同的方法名。

- 存在于父类和子类、同类中。

方法的重写(Overriding)和重载(Overloading)是Java多态性的不同表现。 重写(Overriding)是父类与子类之间多态性的一种表现,而重载(Overloading)是一个类中多态性的一种表现。如果在子类中定义某方法与其父类有相同的名称和参数,我们说该方法被重写 (Overriding)。子类的对象使用这个方法时,将调用子类中的定义,对它而言,父类中的定义如同被"屏蔽"了.

7、string,stringBuffer,stringBuild的区别

- String: 不可变字符串

- StringBuffer:可变字符串,线程安全,效率低

- StringBuild:可变字符串,线程不安全,效率高

8、==和equals的区别

- ==是比较两个对象引用地址是否一样,或者基本类型的值是否相等。

- equals在比较两个对象的时候,要根据对象实现的equals方法

9、&和&&的区别

运算执行:

- 对于:& -- > 不管怎样,都会执行"&"符号左右两边的程序

- 对于:&& -- > 只有当符号"&&"左边程序为真(true)后,才会执行符号"&&"右边的程序。

运算规则:

- 对于:& -- > 只要左右两边有一个为false,则为false;只有全部都为true的时候,结果为true

- 对于:&& -- > 只要符号左边为false,则结果为false;当左边为true,同时右边也为true,则结果为true

10、i++和++i的区别

首先int i=1,a=0;

- i++ 先运算在赋值,例如 a=i++,先运算a=i,后运算i=i+1,所以结果是a==1

- ++i 先赋值在运算,例如 a=++i,先运算i=i+1,后运算a=i,所以结果是a==2

11、hashcode和equals方法

- 只要重写 equals,就必须重写 hashCode。

- 因为 Set 存储的是不重复的对象,依据 hashCode 和 equals 进行判断,所以 Set 存储的对象必须重写这两个方法。

- 如果自定义对象做为 Map 的键,那么必须重写 hashCode 和 equals。

12、hashcode和equals方法的重写原则

- 原则 1 : 如果 x.equals(y) 返回 “true”,那么 x 和 y 的 hashCode() 必须相等 ;

- 原则 2 : 如果 x.equals(y) 返回 “false”,那么 x 和 y 的 hashCode() 有可能相等,也有可能不等 ;

- 原则 3 : 如果 x 和 y 的 hashCode() 不相等,那么 x.equals(y) 一定返回 “false” ;

- 原则 4 : 一般来讲,equals 这个方法是给用户调用的,而 hashcode 方法一般用户不会去调用 ;

- 原则 5 : 当一个对象类型作为集合对象的元素时,那么这个对象应该拥有自己的equals()和hashCode()设计,而且要遵守前面所说的几个原则。

13、值传递和对象传递

- 对于基本类型,是值传递,

- 对于引用类型,是引用传递。

14、所有类的父类是哪个?有哪些方法?

java中所有类的父类是object,有11个方法:

- protected Object clone() 创建并返回此对象的一个副本。

- boolean equals(Object obj) 指示某个其他对象是否与此对象“相等”。

- int hashCode() 返回该对象的哈希码值。

- String toString() 返回该对象的字符串表示。

- protected void finalize() 当垃圾回收器确定不存在对该对象的更多引用时,由对象的垃圾回收器调用此方法。

- Class<? extendsObject> getClass() 返回一个对象的运行时类。

- void notify() 唤醒在此对象监视器上等待的单个线程。

- void notifyAll() 唤醒在此对象监视器上等待的所有线程。

- void wait() 导致当前的线程等待,直到其他线程调用此对象的 notify() 方法或 notifyAll() 方法。

- void wait(long timeout) 导致当前的线程等待,直到其他线程调用此对象的 notify() 方法或 notifyAll() 方法,或者超过指定的时间量。

- void wait(long timeout, int nanos) 导致当前的线程等待,直到其他线程调用此对象的 notify()

15、final,static,this,super关键字总结

final关键字

final关键字主要用在三个地方:变量、方法、类。

对于一个final变量,如果是基本数据类型的变量,则其数值一旦在初始化之后便不能更改;如果是引用类型的变量,则在对其初始化之后便不能再让其指向另一个对象。

当用final修饰一个类时,表明这个类不能被继承。final类中的所有成员方法都会被隐式地指定为final方法。

使用final方法的原因有两个。第一个原因是把方法锁定,以防任何继承类修改它的含义;第二个原因是效率。在早期的Java实现版本中,会将final方法转为内嵌调用。但是如果方法过于庞大,可能看不到内嵌调用带来的任何性能提升(现在的Java版本已经不需要使用final方法进行这些优化了)。类中所有的private方法都隐式地指定为final。

static关键字

- 修饰成员变量和成员方法: 被 static 修饰的成员属于类,不属于单个这个类的某个对象,被类中所有对象共享,可以并且建议通过类名调用。被static 声明的成员变量属于静态成员变量,静态变量 存放在 Java 内存区域的方法区。调用格式:类名.静态变量名 类名.静态方法名()

- 静态代码块: 静态代码块定义在类中方法外, 静态代码块在非静态代码块之前执行(静态代码块—>非静态代码块—>构造方法)。 该类不管创建多少对象,静态代码块只执行一次.

- 静态内部类(static修饰类的话只能修饰内部类): 静态内部类与非静态内部类之间存在一个最大的区别: 非静态内部类在编译完成之后会隐含地保存着一个引用,该引用是指向创建它的外围类,但是静态内部类却没有。没有这个引用就意味着:1. 它的创建是不需要依赖外围类的创建。2. 它不能使用任何外围类的非static成员变量和方法。

- 静态导包(用来导入类中的静态资源,1.5之后的新特性): 格式为:import static 这两个关键字连用可以指定导入某个类中的指定静态资源,并且不需要使用类名调用类中静态成员,可以直接使用类中静态成员变量和成员方法。

this关键字

this关键字用于引用类的当前实例。 例如:

class Manager {

Employees[] employees;

void manageEmployees() {

int totalEmp = this.employees.length;

System.out.println("Total employees: " + totalEmp);

this.report();

}

void report() { }

}

在上面的示例中,this关键字用于两个地方:

- this.employees.length:访问类Manager的当前实例的变量。

- this.report():调用类Manager的当前实例的方法。 此关键字是可选的,这意味着如果上面的示例在不使用此关键字的情况下表现相同。 但是,使用此关键字可能会使代码更易读或易懂。

super关键字

super关键字用于从子类访问父类的变量和方法。 例如:

public class Super {

protected int number;

protected showNumber() {

System.out.println("number = " + number);

}

}

public class Sub extends Super {

void bar() {

super.number = 10;

super.showNumber();

}

}

在上面的例子中,Sub 类访问父类成员变量 number 并调用其其父类 Super 的 showNumber() 方法。 使用 this 和 super 要注意的问题:

- 在构造器中使用 super() 调用父类中的其他构造方法时,该语句必须处于构造器的首行,否则编译器会报错。另外,this 调用本类中的其他构造方法时,也要放在首行。

- this、super不能用在static方法中。

java中二进制操作符号

移位操作符

- ">>" 是带符号右移,若左操作数是正数,则高位补“0”,若左操作数是负数,则高位补“1”.

- "<<" 将左操作数向左边移动,并且在低位补0.

- ">>>" 是无符号右移,无论左操作数是正数还是负数,在高位都补“0”

三种移位符号作用的左操作数有五种:long,int,short,byte,char但是在作用不同的操作数类型时,其具体过程不同, 遵循一下几个原则:

- int移位时,左边的操作数是32位的,此时的移位符号作用在32位bit上。如:1 >> 3, 是将00000000 00000000 00000000 00000001这32位向右边移动3位。

- long 移位时,左边的操作数是64位的,此时移位符号作用在64位bit上。如:1L >> 3。

- short, byte,char 在移位之前首先将数据转换为int,然后再移位,此时移位符号作用在32为bit上。如:(byte)0xff >>> 7, 是将11111111 11111111 11111111 11111111向右边移动7位,得到00000001 11111111 11111111 11111111

- 当左操作数是long时,移位之后得到的类型是long,当左操作数是其它四中类型时,移位之后得到的类型是int,所以如果做操作数是byte,char,short 时,你用 >>=,>>>=, <<= 其实是将得到的int 做低位截取得到的数值。

- 三种移位符号除了对做操作数有操作规则外,其实对右操作数也有操作规则。如果左操作数(转换之后的)是int,那么右操作数只有低5位有效(因为int总共就32位,11111b = 31,所以规定移动32位相当于没有移动)。如:23 >> 33, 结果与23 >>1是一样的,都是11;同理,如果左边操作数是long,那么右边操作数只有低6位有效。

System.out.println(0xff >>> 7);

/*

0xff 本身就是一个int,其bits为:

00000000 00000000 00000000 11111111

无符号向右移动7位, 得到的bits为:

00000000 00000000 00000000 00000001

*/

System.out.println( ((byte) 0xff) >>> 7 );

/*

(byte)0xff 是一个byte,bits为:

11111111

首先转换为int,其bits为:

11111111 11111111 11111111 11111111

向右边无符号移动7为,得到的结果bits是:

00000001 11111111 11111111 11111111

*/

System.out.println( (byte) (((byte) 0xff) >>> 7) );

/*

(byte) 0xff 是一个byte,bits为:

11111111

首先转换为int,其bits为:

11111111 11111111 11111111 11111111

向右边无符号移动7为,得到的结果bits是:

00000001 11111111 11111111 11111111

然后转换为byte,低位截取得到bits:11111111

<在输出的时候转换为int,其bits为:

11111111 11111111 11111111 11111111>

*/

位异或操作(^)

运算规则:两个数转为二进制,然后从高位比较,如果相同则为0,不相同为1。

比如:8^11.

8转为二进制是1000,11转为二进制是1011,从高位开始比较得到的是:0011.然后二进制转为十进制,就是`Integer.parseInt("0011",2)=3;`

位与运算符(&)

运算规则:两个数转为二进制,然后从高位比较,如果两个数都是1则为1,否则为0。

比如:129&128.

129转换成二进制就是10000001,128转换成二进制就是10000000。从高位开始比较得到,得到10000000,即128。

位或运算符(|)

运算规则:两个数都转为二进制,然后从高位开始比较,两个数只要有一个为1则为1,否则为0.

比如:129|128.

129转换成二进制就是10000001,128转换成二进制就是10000000。从高位开始比较得到,得到10000001,即129.

位非运算符(~)

运算规则:如果位为0,结果是1,如果位为1,结果是0.

比如:~37

在Java中,所有数据的表示方法都是以补码的形式表示,如果没有特殊说明,Java中的数据类型默认是int,int数据类型的长度是8位,一位是四个字节,就是32字节,32bit.

8转为二进制是100101.

补码后为: 00000000 00000000 00000000 00100101

取反为: 11111111 11111111 11111111 11011010

因为高位是1,所以原码为负数,负数的补码是其绝对值的原码取反,末尾再加1。

因此,我们可将这个二进制数的补码进行还原:

首先,末尾减1得反码: 11111111 11111111 11111111 11011001

其次,将各位取反得原码:00000000 00000000 00000000 00100110,

此时二进制转原码为38

所以~37 = -38.

参考链接:

https://blog.csdn.net/xuejianbest/article/details/84792311 https://www.cnblogs.com/yesiamhere/p/6675067.html

java EE规范

Java EE(Java Platform, Enterprise Edition),现在更名为 Jakarta EE,是一套用于企业级Java应用开发的规范和技术标准。Java EE提供了一系列API和服务,以支持开发和部署分布式、可扩展、可安全访问的企业级应用程序。以下是Java EE规范的主要方面:

1. Servlet API:

- Servlet是用于处理Web请求和生成动态内容的Java程序。Servlet API定义了与HTTP请求和响应相关的类和接口。

2. JSP(JavaServer Pages):

- JSP允许在Java代码中嵌入HTML,使得动态内容的生成更为简便。JSP是一种模板语言,可用于创建动态Web页面。

3. JPA(Java Persistence API):

- JPA是用于实现对象关系映射(ORM)的规范,用于将Java对象映射到数据库表。它简化了数据持久性的开发。

4. EJB(Enterprise JavaBeans):

- EJB提供了一种构建分布式、事务性企业级应用的标准方式。包括Session Bean、Message-Driven Bean和Entity Bean等组件。

5. JMS(Java Message Service):

- JMS定义了Java平台上的消息中间件的API,用于在分布式系统中进行异步消息通信。

6. JTA(Java Transaction API):

- JTA为Java应用程序提供了分布式事务处理的API。它允许开发者在多个资源上执行事务操作。

7. JCA(Java Connector Architecture):

- JCA定义了一套标准的架构,允许Java EE应用程序与企业信息系统(EIS)进行连接。

8. JavaMail API:

- JavaMail提供了用于发送和接收电子邮件的API,是构建与电子邮件相关的企业级应用程序的标准。

9. Java Authentication and Authorization Service (JAAS):

- JAAS提供了在Java应用程序中进行身份验证和授权的标准API。

10. JAX-RS(Java API for RESTful Web Services):

- JAX-RS是用于构建RESTful Web服务的规范,支持通过HTTP协议进行资源的创建、读取、更新和删除操作。

11. JAXB(Java Architecture for XML Binding):

- JAXB定义了将Java对象与XML文档进行相互转换的标准方式。

12. WebSocket API:

- WebSocket API提供了一种在Web应用程序中进行全双工通信的标准方式。

13. Java EE Connector Architecture:

- Java EE Connector Architecture提供了一种标准的方式,用于连接Java EE应用程序与企业信息系统(EIS)之间的连接器。

Java EE规范的每个版本都引入了新的特性、改进和对新技术的支持。然而,需要注意的是,随着Java EE的发展,Java EE规范已经转交给了Eclipse Foundation,并更名为 Jakarta EE。因此,后续的 Jakarta EE 规范将由 Eclipse Foundation 负责制定和推进。

servlet的生命周期

- 只有一个Servlet对象(要点)

- 第一次请求的时候被初始化,只此一遍

- 初始化后先调用init方法,只此一遍

- 每个请求,调用一遍service -> service -> doGet/doPost。以多线程的方式运行

- 卸载前调用destroy方法

servlet规范

Servlet规范是一组Java API(Application Programming Interface,应用程序编程接口)规范,用于在Java EE(Enterprise Edition,企业版)平台上开发基于HTTP协议的Web应用程序。Servlet是一种Java程序,通过Servlet容器(如Tomcat)运行,用于处理Web请求和生成动态Web内容。

以下是一些关键的Servlet规范特性和概念:

-

Servlet类: Servlet是一个Java类,通常扩展自

javax.servlet.http.HttpServlet类。开发人员需要实现Servlet类,并覆盖一些生命周期方法来处理请求和生成响应。 -

生命周期方法: Servlet生命周期由容器管理。Servlet容器在需要时会调用Servlet的生命周期方法,包括

init()(初始化)、service()(处理请求)、destroy()(销毁)等。 -

请求和响应对象: Servlet使用

HttpServletRequest和HttpServletResponse对象来处理HTTP请求和生成HTTP响应。这些对象封装了与请求和响应相关的信息,例如参数、头部、内容等。 -

URL映射: Servlet通过在

web.xml配置文件或使用注解来定义URL模式,以便Servlet容器能够将特定URL请求映射到相应的Servlet类。 -

Session管理: Servlet规范提供了

HttpSession接口,用于在客户端和服务器之间跟踪用户的会话状态。通过会话,可以在多个请求之间保持用户相关的信息。 -

过滤器: Servlet过滤器是一种机制,允许在请求到达Servlet之前或响应离开Servlet之后执行一些处理。过滤器可用于修改请求、响应,或者执行其他与请求和响应相关的任务。

-

监听器: Servlet规范定义了一些事件和监听器,用于在Web应用程序生命周期中捕获事件。例如,

ServletContextListener可用于在Web应用程序启动和关闭时执行一些操作。 -

异步处理: Servlet规范支持异步处理,允许Servlet在处理请求时挂起线程,而不必等待操作完成。这有助于提高Web应用程序的性能和并发性。

Servlet规范的版本会随着时间推移而更新,每个版本都引入了新的功能和改进。开发人员可以根据Java EE平台的版本选择相应的Servlet规范版本。在现代的Java开发中,Servlet规范通常与Java EE的其他规范一起使用,如JSP(JavaServer Pages)、JNDI(Java Naming and Directory Interface)等。

cookie和session

cookie:客户端保存,大小有限制,容易被篡改 session:服务器保存,大小无限制,

java发展历史

java各个版本发布时间

我们先来看看java成立到现在的所有版本。 1990年初,最初被命名为Oak;

1995年5月23日,Java语言诞生;

1996年1月,第一个JDK-JDK1.0诞生;

1996年4月,10个最主要的操作系统供应商申明将在其产品中嵌入Java技术;

1996年9月,约8.3万个网页应用了Java技术来制作;

1997年2月18日,JDK1.1发布;

1997年4月2日,JavaOne会议召开,参与者逾一万人,创当时全球同类会议纪录;

1997年9月,JavaDeveloperConnection社区成员超过十万;

1998年2月,JDK1.1被下载超过2,000,000次;

1998年12月8日,Java 2企业平台J2EE发布;

1999年6月,SUN公司发布Java三个版本:标准版(J2SE)、企业版(J2EE)和微型版(J2ME);

2000年5月8日,JDK1.3发布;

2000年5月29日,JDK1.4发布;

2001年6月5日,Nokia宣布到2003年将出售1亿部支持Java的手机;

2001年9月24日,J2EE1.3发布;

2002年2月26日,J2SE1.4发布,此后Java的计算能力有了大幅提升;

2004年9月30日,J2SE1.5发布,成为Java语言发展史上的又一里程碑。为了表示该版本的重要性,J2SE1.5更名为Java SE 5.0;

2005年6月,JavaOne大会召开,SUN公司公开Java SE 6。此时,Java的各种版本已经更名,以取消其中的数字“2”:J2EE更名为Java EE,J2SE更名为Java SE,J2ME更名为Java ME;

2006年12月,SUN公司发布JRE6.0;

2009年4月20日,甲骨文以74亿美元的价格收购SUN公司,取得java的版权,业界传闻说这对Java程序员是个坏消息(其实恰恰相反);

2010年11月,由于甲骨文对Java社区的不友善,因此Apache扬言将退出JCP;

2011年7月28日,甲骨文发布Java SE 7;

2014年3月18日,甲骨文发表Java SE 8;

2017年7月,甲骨文发表Java SE 9。

jdk1.5

- 自动装箱和拆箱

- 枚举

- 静态导入

- 可变参数

- 内省

- 泛型

- for-each循环

jdk1.6

- Desktop和systemtTray

- 使用JAXB2来实现对象与XML之间的映射

- 理解StAX

- 使用Compiler API

- 轻量级Http Server API

- 插入式注解处理API(Pluggable Annotation Processing API)

- 用Console开发控制台程序

- 对脚本语言的支持如: ruby, groovy, javascript.

- Common Annotations

jdk1.7

- switch中可以使用字串了

- 泛型实例化类型自动推断

- 自定义自动关闭类,自动关闭资源

- 新增一些取环境信息的工具方法

- Boolean类型反转,空指针安全,参与位运算

- 两个char间的equals

- 安全的加减乘除

- 对Java集合(Collections)的增强支持

- try catch异常扑捉中,一个catch可以写多个异常类型,用"|"隔开

- 支持二进制文字

jdk8

- 接口的默认方法

- Lambda 表达式

- 函数式接口

- 方法与构造函数引用

- lambda访问局部变量

- Date api更新

jdk9

- 实现模块化系统

- HTTP/2支持,package:java.net.http

- JShell

- 不可变集合工厂方法

- 私有接口方法

- HTML5风格的Java帮助文档

- 多版本兼容 JAR

- 统一 JVM 日志

- G1设置为默认垃圾回收

- I/O 流新特性

jdk10

- 局部变量的类型推断

- 将 JDK 的多个代码仓库合并到一个储存库中

- 垃圾收集器接口

- 向 G1 引入并行 Full GC

- 应用类数据共享。

- 线程局部管控。允许停止单个线程,而不是只能启用或停止所有线程

- 移除 Native-Header Generation Tool (javah)

- 额外的 Unicode 语言标签扩展。包括:cu (货币类型)、fw (每周第一天为星期几)、rg (区域覆盖)、tz (时区)

- 在备用内存设备上分配堆内存。允许 HotSpot 虚拟机在备用内存设备上分配 Java 对象堆

- 基于 Java 的 JIT 编译器(试验版本)

- 根证书。开源 Java SE Root CA 程序中的根证书

- 基于时间的版本发布模式。“Feature releases” 版本将包含新特性,“Update releases” 版本仅修复 Bug

jdk11

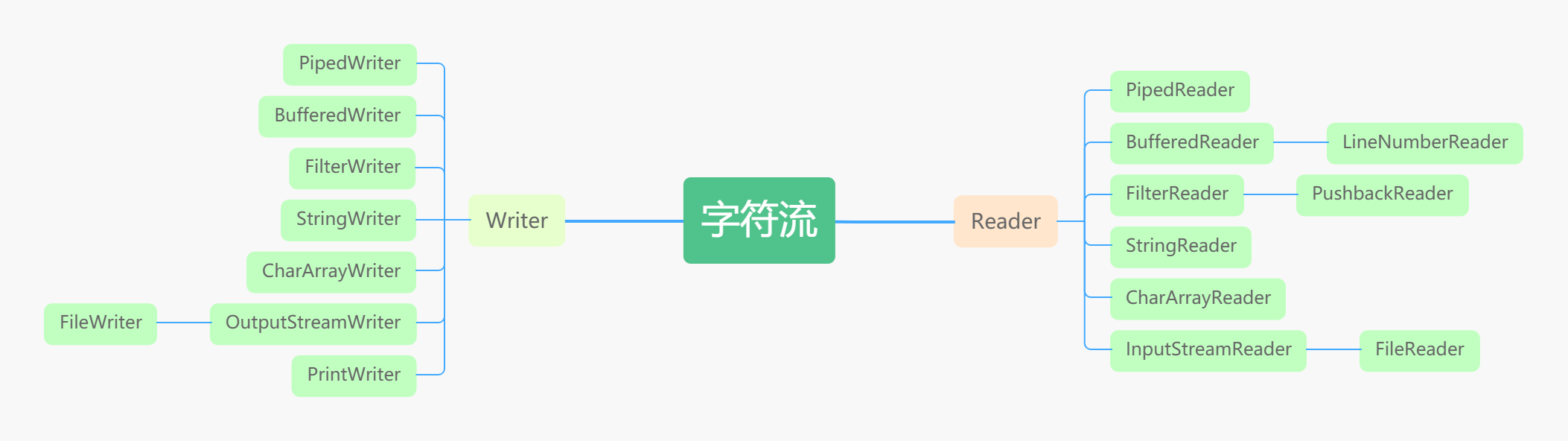

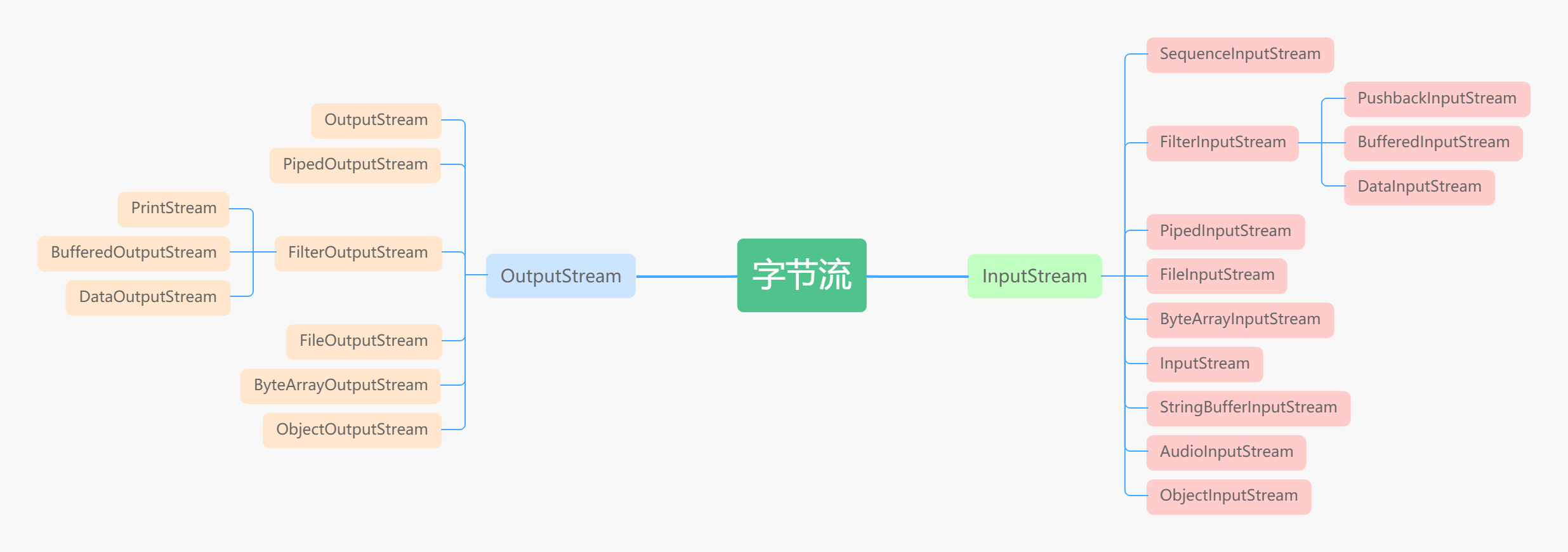

javaIo流详解

字节流和字符流的区别

字节流读取的时候,读到一个字节就返回一个字节; 字符流使用了字节流读到一个或多个字节(中文对应的字节 数是两个,在 UTF-8 码表中是 3 个字节)时。先去查指定的编码表,将查到的字符返回。 字节流可以处理所有类型数 据,如:图片,MP3,AVI 视频文件,而字符流只能处理字符数据。只要是处理纯文本数据,就要优先考虑使用字符 流,除此之外都用字节流。字节流主要是操作 byte 类型数据,以 byte 数组为准,主要操作类就是 OutputStream、 InputStream

字符流处理的单元为 2 个字节的 Unicode 字符,分别操作字符、字符数组或字符串,而字节流处理单元为 1 个字 节,操作字节和字节数组。所以字符流是由 Java 虚拟机将字节转化为2个字节的 Unicode 字符为单位的字符而成的, 所以它对多国语言支持性比较好!如果是音频文件、图片、歌曲,就用字节流好点,如果是关系到中文(文本)的,用字符流好点。在程序中一个字符等于两个字节,java 提供了 Reader、Writer两个专门操作字符流的类。

字节流如何转为字符流

字节输入流转字符输入流通过 InputStreamReader 实现,该类的构造函数可以传入 InputStream 对象。 字节输出流转字符输出流通过 OutputStreamWriter 实现,该类的构造函数可以传入 OutputStream 对象。

字符流类图

字节流类图

bio定义

BIO (Blocking I/O): 同步阻塞I/O模式,数据的读取写入必须阻塞在一个线程内等待其完成。在活动连接数不是特别高(小于单机1000)的情况下,这种模型是比较不错的,可以让每一个连接专注于自己的 I/O 并且编程模型简单,也不用过多考虑系统的过载、限流等问题。线程池本身就是一个天然的漏斗,可以缓冲一些系统处理不了的连接或请求。但是,当面对十万甚至百万级连接的时候,传统的 BIO 模型是无能为力的。因此,我们需要一种更高效的 I/O 处理模型来应对更高的并发量。

bio实现文件读写

/**

* BIO模式

* FileReader逐个字符读取文件,FileReader extends InputStreamReader

* 读取文件中内容到字符数组中

* 如何确定字符数组长度:

* FileReader不能自定义编码读取

* 此方法也可以用于读取二进制文件,只不过读取出来有很多乱码

* @param fileName

* @return

* @throws IOException

*/

public static char[] readByOneCharWithDefaultEncoding(String fileName) throws IOException{

File file = new File(fileName);

FileReader fileReader = new FileReader(file); // 不能自定义编码,内部默认采用系统的编码

System.out.println("当前采用编码: " + fileReader.getEncoding());

char[] charcters = new char[1024];

int result = fileReader.read(); // 逐个字符读取,不能按行读取

int i = 0;

while(result != -1 && i < 1024){

char temp = (char)result;

charcters[i] = temp;

i++;

result = fileReader.read();

}

fileReader.close();

return charcters;

}

bio服务器

//BIO服务端源码

public final class ServerNormal {

//默认的端口号

private static int DEFAULT_PORT = 12345;

//单例的ServerSocket

private static ServerSocket server;

//根据传入参数设置监听端口,如果没有参数调用以下方法并使用默认值

public static void start() throws IOException{

//使用默认值

start(DEFAULT_PORT);

}

//这个方法不会被大量并发访问,不太需要考虑效率,直接进行方法同步就行了

public synchronized static void start(int port) throws IOException{

if(server != null) return;

try{

//通过构造函数创建ServerSocket

//如果端口合法且空闲,服务端就监听成功

server = new ServerSocket(port);

System.out.println("服务器已启动,端口号:" + port);

//通过无线循环监听客户端连接

//如果没有客户端接入,将阻塞在accept操作上。

while(true){

Socket socket = server.accept();

//当有新的客户端接入时,会执行下面的代码

//然后创建一个新的线程处理这条Socket链路

new Thread(new ServerHandler(socket)).start();

}

}finally{

//一些必要的清理工作

if(server != null){

System.out.println("服务器已关闭。");

server.close();

server = null;

}

}

}

}

bio的服务处理handler

/**

* 客户端线程

*/

public class ServerHandler implements Runnable{

private Socket socket;

public ServerHandler(Socket socket) {

this.socket = socket;

}

@Override

public void run() {

BufferedReader in = null;

PrintWriter out = null;

try{

in = new BufferedReader(new InputStreamReader(socket.getInputStream()));

out = new PrintWriter(socket.getOutputStream(),true);

String expression;

String result;

while(true){

//通过BufferedReader读取一行

//如果已经读到输入流尾部,返回null,退出循环

//如果得到非空值,就尝试计算结果并返回

if((expression = in.readLine())==null) break;

System.out.println("服务器收到消息:" + expression);

try{

result = Calculator.cal(expression).toString();

}catch(Exception e){

result = "计算错误:" + e.getMessage();

}

out.println(result);

}

}catch(Exception e){

e.printStackTrace();

}finally{

//一些必要的清理工作

if(in != null){

try {

in.close();

} catch (IOException e) {

e.printStackTrace();

}

in = null;

}

if(out != null){

out.close();

out = null;

}

if(socket != null){

try {

socket.close();

} catch (IOException e) {

e.printStackTrace();

}

socket = null;

}

}

}

}

bio客户端

/**

* 阻塞式I/O创建的客户端

*/

public class Client {

//默认的端口号

private static int DEFAULT_SERVER_PORT = 12345;

private static String DEFAULT_SERVER_IP = "127.0.0.1";

public static void send(String expression){

send(DEFAULT_SERVER_PORT,expression);

}

public static void send(int port,String expression){

System.out.println("算术表达式为:" + expression);

Socket socket = null;

BufferedReader in = null;

PrintWriter out = null;

try{

socket = new Socket(DEFAULT_SERVER_IP,port);

in = new BufferedReader(new InputStreamReader(socket.getInputStream()));

out = new PrintWriter(socket.getOutputStream(),true);

out.println(expression);

System.out.println("___结果为:" + in.readLine());

}catch(Exception e){

e.printStackTrace();

}finally{

//一下必要的清理工作

if(in != null){

try {

in.close();

} catch (IOException e) {

e.printStackTrace();

}

in = null;

}

if(out != null){

out.close();

out = null;

}

if(socket != null){

try {

socket.close();

} catch (IOException e) {

e.printStackTrace();

}

socket = null;

}

}

}

}

java Nio原理

io和NIO的区别

IO:面向流,阻塞IO NIO:面向缓冲,非阻塞IO,选择器 NIO (New I/O): NIO是一种同步非阻塞的I/O模型,在Java 1.4 中引入了NIO框架,对应 java.nio 包,提供了 Channel , Selector,Buffer等抽象。NIO中的N可以理解为Non-blocking,不单纯是New。它支持面向缓冲的,基于通道的I/O操作方法。 NIO提供了与传统BIO模型中的 Socket 和 ServerSocket 相对应的 SocketChannel 和 ServerSocketChannel 两种不同的套接字通道实现,两种通道都支持阻塞和非阻塞两种模式。阻塞模式使用就像传统中的支持一样,比较简单,但是性能和可靠性都不好;非阻塞模式正好与之相反。对于低负载、低并发的应用程序,可以使用同步阻塞I/O来提升开发速率和更好的维护性;对于高负载、高并发的(网络)应用,应使用 NIO 的非阻塞模式来开发

Java NIO 由以下几个核心部分组成:

- Channels

- Buffers:与channel可以相互存取数据

- Selectors:允许单线程处理多个 Channel

常用的channel

- FileChannel 从文件中读写数据。

- DatagramChannel 能通过 UDP 读写网络中的数据。

- SocketChannel 能通过 TCP 读写网络中的数据。

- ServerSocketChannel 可以监听TCP连接,像Web服务器那样。对每一个新进来的连接都会创建一个 SocketChannel。

- DatagramChannel是一个能收发UDP包的通道。因为UDP是无连接的网络协议,所以不能像其它通道那样读取和写入。它发送和接收的是数据包。

nio实现文件读写

nio实现简单服务器

nio实现客户端

java aio定义

AIO (Asynchronous I/O): AIO 也就是 NIO 2。在 Java 7 中引入了 NIO 的改进版 NIO 2,它是异步非阻塞的IO模型。异步 IO 是基于事件和回调机制实现的,也就是应用操作之后会直接返回,不会堵塞在那里,当后台处理完成,操作系统会通知相应的线程进行后续的操作。AIO 是异步IO的缩写,虽然 NIO 在网络操作中,提供了非阻塞的方法,但是 NIO 的 IO 行为还是同步的。

java aio的实现

在Java中,异步I/O主要通过以下两个类来实现:

-

AsynchronousChannelGroup:

AsynchronousChannelGroup是一个可以用于管理异步通道的组。异步通道是支持异步I/O操作的通道,例如AsynchronousSocketChannel和AsynchronousFileChannel。

-

AsynchronousChannel:

AsynchronousChannel是一个支持异步I/O操作的通道接口,包括读取和写入。常见的实现类有AsynchronousSocketChannel和AsynchronousFileChannel。

下面是一个简单的使用异步I/O的例子,使用AsynchronousFileChannel进行文件读取:

import java.nio.ByteBuffer;

import java.nio.channels.AsynchronousFileChannel;

import java.nio.channels.CompletionHandler;

import java.nio.file.Path;

import java.nio.file.Paths;

import java.util.concurrent.ExecutorService;

import java.util.concurrent.Executors;

public class AsyncFileIOExample {

public static void main(String[] args) {

try {

Path filePath = Paths.get("example.txt");

AsynchronousFileChannel fileChannel = AsynchronousFileChannel.open(filePath);

ByteBuffer buffer = ByteBuffer.allocate(1024);

ExecutorService executor = Executors.newFixedThreadPool(10);

fileChannel.read(buffer, 0, buffer, new CompletionHandler<Integer, ByteBuffer>() {

@Override

public void completed(Integer result, ByteBuffer attachment) {

System.out.println("Read " + result + " bytes");

attachment.flip();

System.out.println("Content: " + new String(attachment.array()));

}

@Override

public void failed(Throwable exc, ByteBuffer attachment) {

System.err.println("Error: " + exc.getMessage());

}

});

// Do other tasks while the I/O operation is in progress

executor.shutdown();

} catch (Exception e) {

e.printStackTrace();

}

}

}

在上述例子中,文件读取操作是异步的,CompletionHandler用于在I/O操作完成时得到通知。在实际应用中,异步I/O常用于处理大量的并发连接或需要进行并行I/O操作的场景,以提高系统的性能和响应速度。

java集合总结:集合的数据结构和性能对比

相比c或者c++而言,java提供了丰富的集合工具类,开发者几乎开箱即用。不需要自定义一堆集合类。

集合遍历方式

- 普通for循环

- for Each循环

- Iterator迭代

- lam 表达式

list

功能:动态的数组,存普通的列表数据,有序。 ArrayList(数据结构) LinkedList(链表结构)

循环删除元素:Iterator(迭代器循环)

set

功能:用于去重,存储不同的元素,没有顺序。 HashSet LinkedHashSet

map

功能:存储key-value类型的数据,key不允许重复,没有顺序 HashMap LinkedHashMap(有序) TreeMap(能排序)

并发容器

功能:用于多线程场景下并发安全的容器。 ConrrentHashMap HashTable(悲观锁) Vector(悲观锁)

Java的基本数据类型都有哪些各占几个字节?

- byte 1

- boolean 1(boolean 类型比较特别可能只占一个 bit,多个 boolean 可能共同占用一个字节)

- char 2

- short 2

- int 4

- float 4

- double 8

- long 8

java集合类图

所有的集合类,都实现了Iterator接口,这是一个用于遍历集合中元素的接口,主要包含 hashNext(),next(),remove()三种方法。它的一个子接口LinkedIterator在它的基础上又添加了三种方法,分别是 add(),previous(),hasPrevious()。也就是说如果是先Iterator接口,那么在遍历集合中元素的时候,只能往后遍历,被 遍历后的元素不会在遍历到,通常无序集合实现的都是这个接口,比如HashSet,HashMap;

而那些元素有序的集合,实现的一般都是 LinkedIterator接口,实现这个接口的集合可以双向遍历,既可以通过next()访问下一个元素,又可以通过previous()访问前一个 元素,比如ArrayList。

数组

数组性能最高,但是无法动态扩容,操作不方便。

ArrayList(jdk1.8)

实现了List

初始化容量:10 当容量满的时候进行扩容:

private static final int DEFAULT_CAPACITY = 10;

int newCapacity = oldCapacity + (oldCapacity >> 1);

ArrayList 的底层是数组队列,相当于动态数组。与 Java 中的数组相比,它的容量能动态增长。在添加大量元素前,应用程序可以使用ensureCapacity操作来增加 ArrayList 实例的容量。这可以减少递增式再分配的数量。

它继承于 AbstractList,实现了 List, RandomAccess, Cloneable, java.io.Serializable 这些接口。

在我们学数据结构的时候就知道了线性表的顺序存储,插入删除元素的时间复杂度为O(n),求表长以及增加元素,取第 i 元素的时间复杂度为O(1)

ArrayList 继承了AbstractList,实现了List。它是一个数组队列,提供了相关的添加、删除、修改、遍历等功能。

ArrayList 实现了RandomAccess 接口, RandomAccess 是一个标志接口,表明实现这个这个接口的 List 集合是支持快速随机访问的。在 ArrayList 中,我们即可以通过元素的序号快速获取元素对象,这就是快速随机访问。

ArrayList 实现了Cloneable 接口,即覆盖了函数 clone(),能被克隆。

ArrayList 实现java.io.Serializable 接口,这意味着ArrayList支持序列化,能通过序列化去传输。和 Vector 不同,ArrayList 中的操作不是线程安全的!所以,建议在单线程中才使用 ArrayList,而在多线程中可以选择 Vector 或者 CopyOnWriteArrayList。

LinkedList

实现了List

底层数据结构是一个双向链表。可以在任何位置进行高效地插入和删除操作的有序序列。

ArrayList和LinkedList区别

- **线程安全:**ArrayList 和 LinkedList 都是不同步的,也就是不保证线程安全;

- **数据结构:**ArrayList是实现了基于动态数组的数据结构,LinkedList基于双向链表的数据结构。

- **是否支持快速随机访问:**对于随机访问get和set,ArrayList优于LinkedList,时间复杂度位O(1),因为LinkedList要移动指针,ArrayList口语通过下标访问。

- 对于新增和删除操作add和remove,LinkedList比较占优势,时间复杂度位O(1),因为ArrayList要移动数据,而LinkedList。

- 内存空间占用: ArrayList的空 间浪费主要体现在在list列表的结尾会预留一定的容量空间,而LinkedList的空间花费则体现在它的每一个元素都需要消耗比ArrayList更多的空间(因为要存放直接后继和直接前驱以及数据)。

一 先从 ArrayList 的构造函数说起

ArrayList有三种方式来初始化,构造方法源码如下:

/**

* 默认初始容量大小

*/

private static final int DEFAULT_CAPACITY = 10;

private static final Object[] DEFAULTCAPACITY_EMPTY_ELEMENTDATA = {};

/**

*默认构造函数,使用初始容量10构造一个空列表(无参数构造)

*/

public ArrayList() {

this.elementData = DEFAULTCAPACITY_EMPTY_ELEMENTDATA;

}

/**

* 带初始容量参数的构造函数。(用户自己指定容量)

*/

public ArrayList(int initialCapacity) {

if (initialCapacity > 0) {//初始容量大于0

//创建initialCapacity大小的数组

this.elementData = new Object[initialCapacity];

} else if (initialCapacity == 0) {//初始容量等于0

//创建空数组

this.elementData = EMPTY_ELEMENTDATA;

} else {//初始容量小于0,抛出异常

throw new IllegalArgumentException("Illegal Capacity: "+

initialCapacity);

}

}

/**

*构造包含指定collection元素的列表,这些元素利用该集合的迭代器按顺序返回

*如果指定的集合为null,throws NullPointerException。

*/

public ArrayList(Collection<? extends E> c) {

elementData = c.toArray();

if ((size = elementData.length) != 0) {

// c.toArray might (incorrectly) not return Object[] (see 6260652)

if (elementData.getClass() != Object[].class)

elementData = Arrays.copyOf(elementData, size, Object[].class);

} else {

// replace with empty array.

this.elementData = EMPTY_ELEMENTDATA;

}

}

细心的同学一定会发现 :以无参数构造方法创建 ArrayList 时,实际上初始化赋值的是一个空数组。当真正对数组进行添加元素操作时,才真正分配容量。即向数组中添加第一个元素时,数组容量扩为10。 下面在我们分析 ArrayList 扩容时会讲到这一点内容!

二 一步一步分析 ArrayList 扩容机制

这里以无参构造函数创建的 ArrayList 为例分析

1. 先来看 add 方法

/**

* 将指定的元素追加到此列表的末尾。

*/

public boolean add(E e) {

//添加元素之前,先调用ensureCapacityInternal方法

ensureCapacityInternal(size + 1); // Increments modCount!!

//这里看到ArrayList添加元素的实质就相当于为数组赋值

elementData[size++] = e;

return true;

}

2. 再来看看 ensureCapacityInternal() 方法

可以看到 add 方法 首先调用了ensureCapacityInternal(size + 1)

//得到最小扩容量

private void ensureCapacityInternal(int minCapacity) {

if (elementData == DEFAULTCAPACITY_EMPTY_ELEMENTDATA) {

// 获取默认的容量和传入参数的较大值

minCapacity = Math.max(DEFAULT_CAPACITY, minCapacity);

}

ensureExplicitCapacity(minCapacity);

}

当 要 add 进第1个元素时,minCapacity为1,在Math.max()方法比较后,minCapacity 为10。

3. ensureExplicitCapacity() 方法

如果调用 ensureCapacityInternal() 方法就一定会进过(执行)这个方法,下面我们来研究一下这个方法的源码!

//判断是否需要扩容

private void ensureExplicitCapacity(int minCapacity) {

modCount++;

// overflow-conscious code

if (minCapacity - elementData.length > 0)

//调用grow方法进行扩容,调用此方法代表已经开始扩容了

grow(minCapacity);

}

我们来仔细分析一下:

- 当我们要 add 进第1个元素到 ArrayList 时,elementData.length 为0 (因为还是一个空的 list),因为执行了

ensureCapacityInternal()方法 ,所以 minCapacity 此时为10。此时,minCapacity - elementData.length > 0成立,所以会进入grow(minCapacity)方法。 - 当add第2个元素时,minCapacity 为2,此时e lementData.length(容量)在添加第一个元素后扩容成 10 了。此时,

minCapacity - elementData.length > 0不成立,所以不会进入 (执行)grow(minCapacity)方法。 - 添加第3、4···到第10个元素时,依然不会执行grow方法,数组容量都为10。

直到添加第11个元素,minCapacity(为11)比elementData.length(为10)要大。进入grow方法进行扩容。

4. grow() 方法

/**

* 要分配的最大数组大小

*/

private static final int MAX_ARRAY_SIZE = Integer.MAX_VALUE - 8;

/**

* ArrayList扩容的核心方法。

*/

private void grow(int minCapacity) {

// oldCapacity为旧容量,newCapacity为新容量

int oldCapacity = elementData.length;

//将oldCapacity 右移一位,其效果相当于oldCapacity /2,

//我们知道位运算的速度远远快于整除运算,整句运算式的结果就是将新容量更新为旧容量的1.5倍,

int newCapacity = oldCapacity + (oldCapacity >> 1);

//然后检查新容量是否大于最小需要容量,若还是小于最小需要容量,那么就把最小需要容量当作数组的新容量,

if (newCapacity - minCapacity < 0)

newCapacity = minCapacity;

// 如果新容量大于 MAX_ARRAY_SIZE,进入(执行) `hugeCapacity()` 方法来比较 minCapacity 和 MAX_ARRAY_SIZE,

//如果minCapacity大于最大容量,则新容量则为`Integer.MAX_VALUE`,否则,新容量大小则为 MAX_ARRAY_SIZE 即为 `Integer.MAX_VALUE - 8`。

if (newCapacity - MAX_ARRAY_SIZE > 0)

newCapacity = hugeCapacity(minCapacity);

// minCapacity is usually close to size, so this is a win:

elementData = Arrays.copyOf(elementData, newCapacity);

}

int newCapacity = oldCapacity + (oldCapacity >> 1),所以 ArrayList 每次扩容之后容量都会变为原来的 1.5 倍!(JDK1.6版本以后) JDk1.6版本时,扩容之后容量为 1.5 倍+1!详情请参考源码

">>"(移位运算符):>>1 右移一位相当于除2,右移n位相当于除以 2 的 n 次方。这里 oldCapacity 明显右移了1位所以相当于oldCapacity /2。对于大数据的2进制运算,位移运算符比那些普通运算符的运算要快很多,因为程序仅仅移动一下而已,不去计算,这样提高了效率,节省了资源 我们再来通过例子探究一下

grow()方法 :

- 当add第1个元素时,oldCapacity 为0,经比较后第一个if判断成立,newCapacity = minCapacity(为10)。但是第二个if判断不会成立,即newCapacity 不比 MAX_ARRAY_SIZE大,则不会进入

hugeCapacity方法。数组容量为10,add方法中 return true,size增为1。 - 当add第11个元素进入grow方法时,newCapacity为15,比minCapacity(为11)大,第一个if判断不成立。新容量没有大于数组最大size,不会进入hugeCapacity方法。数组容量扩为15,add方法中return true,size增为11。

- 以此类推······

这里补充一点比较重要,但是容易被忽视掉的知识点:

- java 中的

length属性是针对数组说的,比如说你声明了一个数组,想知道这个数组的长度则用到了 length 这个属性. - java 中的

length()方法是针对字符串说的,如果想看这个字符串的长度则用到length()这个方法. - java 中的

size()方法是针对泛型集合说的,如果想看这个泛型有多少个元素,就调用此方法来查看!

5. hugeCapacity() 方法。

从上面 grow() 方法源码我们知道: 如果新容量大于 MAX_ARRAY_SIZE,进入(执行) hugeCapacity() 方法来比较 minCapacity 和 MAX_ARRAY_SIZE,如果minCapacity大于最大容量,则新容量则为Integer.MAX_VALUE,否则,新容量大小则为 MAX_ARRAY_SIZE 即为 Integer.MAX_VALUE - 8。

private static int hugeCapacity(int minCapacity) {

if (minCapacity < 0) // overflow

throw new OutOfMemoryError();

//对minCapacity和MAX_ARRAY_SIZE进行比较

//若minCapacity大,将Integer.MAX_VALUE作为新数组的大小

//若MAX_ARRAY_SIZE大,将MAX_ARRAY_SIZE作为新数组的大小

//MAX_ARRAY_SIZE = Integer.MAX_VALUE - 8;

return (minCapacity > MAX_ARRAY_SIZE) ?

Integer.MAX_VALUE :

MAX_ARRAY_SIZE;

}

三 System.arraycopy() 和 Arrays.copyOf()方法

阅读源码的话,我们就会发现 ArrayList 中大量调用了这两个方法。比如:我们上面讲的扩容操作以及add(int index, E element)、toArray() 等方法中都用到了该方法!

3.1 System.arraycopy() 方法

/**

* 在此列表中的指定位置插入指定的元素。

*先调用 rangeCheckForAdd 对index进行界限检查;然后调用 ensureCapacityInternal 方法保证capacity足够大;

*再将从index开始之后的所有成员后移一个位置;将element插入index位置;最后size加1。

*/

public void add(int index, E element) {

rangeCheckForAdd(index);

ensureCapacityInternal(size + 1); // Increments modCount!!

//arraycopy()方法实现数组自己复制自己

//elementData:源数组;index:源数组中的起始位置;elementData:目标数组;index + 1:目标数组中的起始位置; size - index:要复制的数组元素的数量;

System.arraycopy(elementData, index, elementData, index + 1, size - index);

elementData[index] = element;

size++;

}

我们写一个简单的方法测试以下:

public class ArraycopyTest {

public static void main(String[] args) {

// TODO Auto-generated method stub

int[] a = new int[10];

a[0] = 0;

a[1] = 1;

a[2] = 2;

a[3] = 3;

System.arraycopy(a, 2, a, 3, 3);

a[2]=99;

for (int i = 0; i < a.length; i++) {

System.out.println(a[i]);

}

}

}

结果:

0 1 99 2 3 0 0 0 0 0

3.2 Arrays.copyOf()方法

/**

以正确的顺序返回一个包含此列表中所有元素的数组(从第一个到最后一个元素); 返回的数组的运行时类型是指定数组的运行时类型。

*/

public Object[] toArray() {

//elementData:要复制的数组;size:要复制的长度

return Arrays.copyOf(elementData, size);

}

个人觉得使用 Arrays.copyOf()方法主要是为了给原有数组扩容,测试代码如下:

public class ArrayscopyOfTest {

public static void main(String[] args) {

int[] a = new int[3];

a[0] = 0;

a[1] = 1;

a[2] = 2;

int[] b = Arrays.copyOf(a, 10);

System.out.println("b.length"+b.length);

}

}

结果:

10

3.3 两者联系和区别

联系:

看两者源代码可以发现 copyOf() 内部实际调用了 System.arraycopy() 方法

区别:

arraycopy() 需要目标数组,将原数组拷贝到你自己定义的数组里或者原数组,而且可以选择拷贝的起点和长度以及放入新数组中的位置 copyOf() 是系统自动在内部新建一个数组,并返回该数组。

四 ensureCapacity方法

ArrayList 源码中有一个 ensureCapacity 方法不知道大家注意到没有,这个方法 ArrayList 内部没有被调用过,所以很显然是提供给用户调用的,那么这个方法有什么作用呢?

/**

如有必要,增加此 ArrayList 实例的容量,以确保它至少可以容纳由minimum capacity参数指定的元素数。

*

* @param minCapacity 所需的最小容量

*/

public void ensureCapacity(int minCapacity) {

int minExpand = (elementData != DEFAULTCAPACITY_EMPTY_ELEMENTDATA)

// any size if not default element table

? 0

// larger than default for default empty table. It's already

// supposed to be at default size.

: DEFAULT_CAPACITY;

if (minCapacity > minExpand) {

ensureExplicitCapacity(minCapacity);

}

}

最好在 add 大量元素之前用 ensureCapacity 方法,以减少增量重新分配的次数

我们通过下面的代码实际测试以下这个方法的效果:

public class EnsureCapacityTest {

public static void main(String[] args) {

ArrayList<Object> list = new ArrayList<Object>();

final int N = 10000000;

long startTime = System.currentTimeMillis();

for (int i = 0; i < N; i++) {

list.add(i);

}

long endTime = System.currentTimeMillis();

System.out.println("使用ensureCapacity方法前:"+(endTime - startTime));

list = new ArrayList<Object>();

long startTime1 = System.currentTimeMillis();

list.ensureCapacity(N);

for (int i = 0; i < N; i++) {

list.add(i);

}

long endTime1 = System.currentTimeMillis();

System.out.println("使用ensureCapacity方法后:"+(endTime1 - startTime1));

}

}

运行结果:

使用ensureCapacity方法前:4637

使用ensureCapacity方法后:241

通过运行结果,我们可以很明显的看出向 ArrayList 添加大量元素之前最好先使用ensureCapacity 方法,以减少增量重新分配的次数

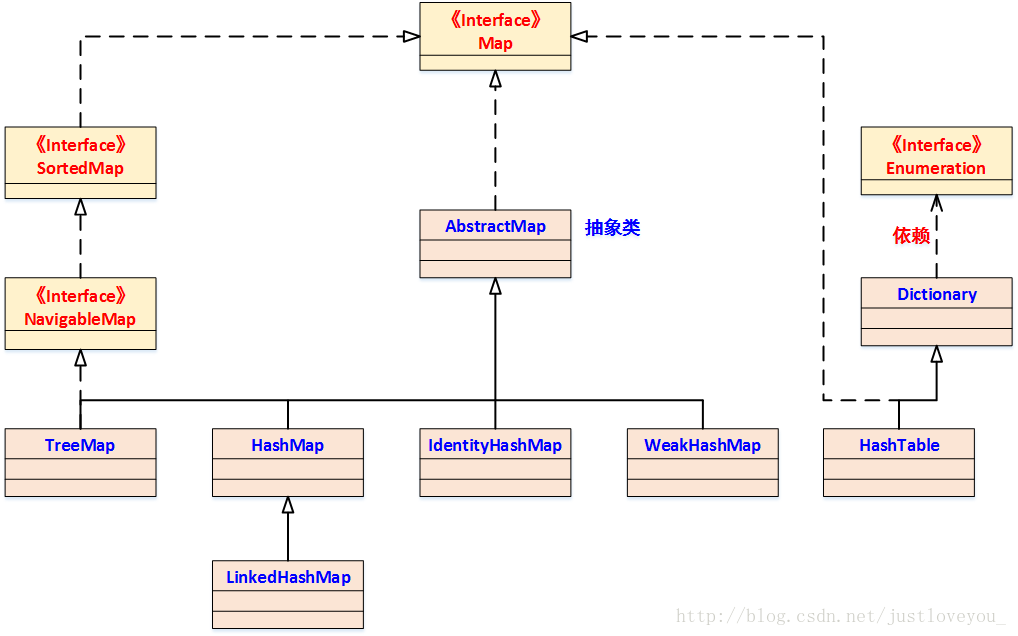

map简介

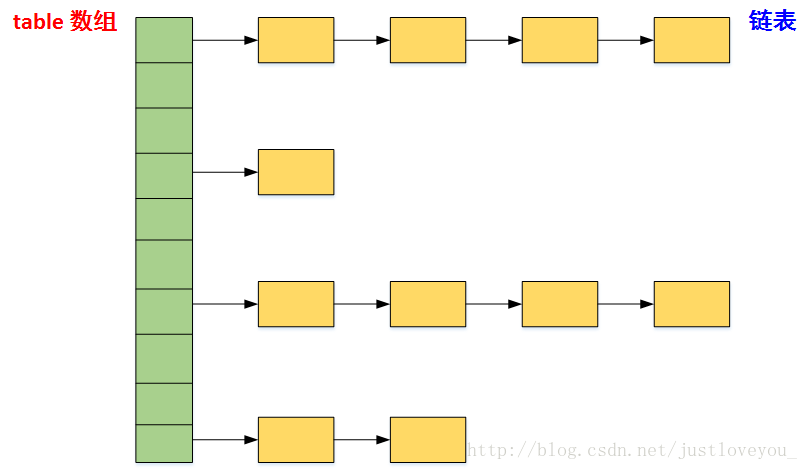

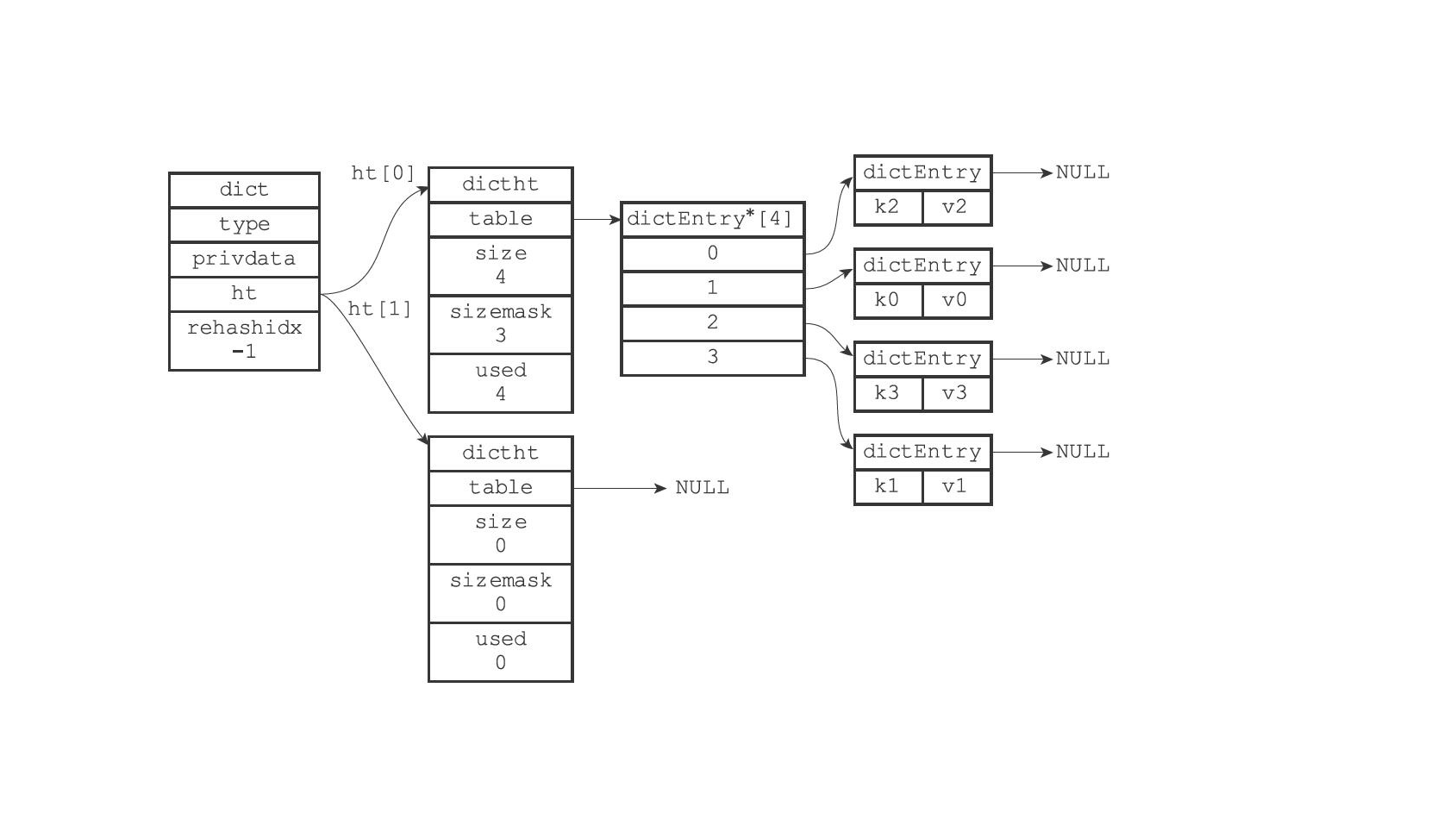

hashMap

数据结构是数组+链表。

初始化

初始容量:16

static final int DEFAULT_INITIAL_CAPACITY = 1 << 4; // aka 16

static final float DEFAULT_LOAD_FACTOR = 0.75f; //负载因子

static final int TREEIFY_THRESHOLD = 8;//链表长度>=8转为红黑树

static final int UNTREEIFY_THRESHOLD = 6;

static final int MIN_TREEIFY_CAPACITY = 64;

put元素的流程

- 检查table的size==0,如果为0,初始化table

- 首先根据对象计算hashcode值,映射到map中数组的下标,如果改数组没有元素,new Node()直接放置。

- 如果有元素,key是否一样,如果key一样,直接替换value。

- key不一样,说明有hash冲突,node是否可以转换为TreeNode,可以转换的话,使用TreeNode的put方法。不能转为TreeNode,放到数组下标对应的链表上,如果链表长度>=8,转为红黑树。

- 判断size>loadFactor,如果到达阈值,触发扩容,进行rehash

get元素的逻辑

- 首先根据对象计算hashcode值,映射到map中数组的下标。

- 如果是一个元素,就直接返回。

- 如果是一个链表,遍历链表,根据key值判断元素,返回。不存在hash冲突的情况下,时间复杂度是o(1)。

hash冲突、hash碰撞

碰撞处理:常用的有四种方式,

- 开放定址法(线性探测,二次探测,伪随机探测)

- 拉链法

- 再散列法(双重散列,多重散列)

- 建立一个公共溢出区

hashmap负载因子为什么是0.75

hashmap容量永远不会用完,当容量达到0.75的时候就会扩容,也就意味着四分之一的空间浪费。 当数组下标剩余很少的时候,出现hash冲突的概率大大增加。0.75是统计学的数据,是空间和效率之间的一个平衡值。

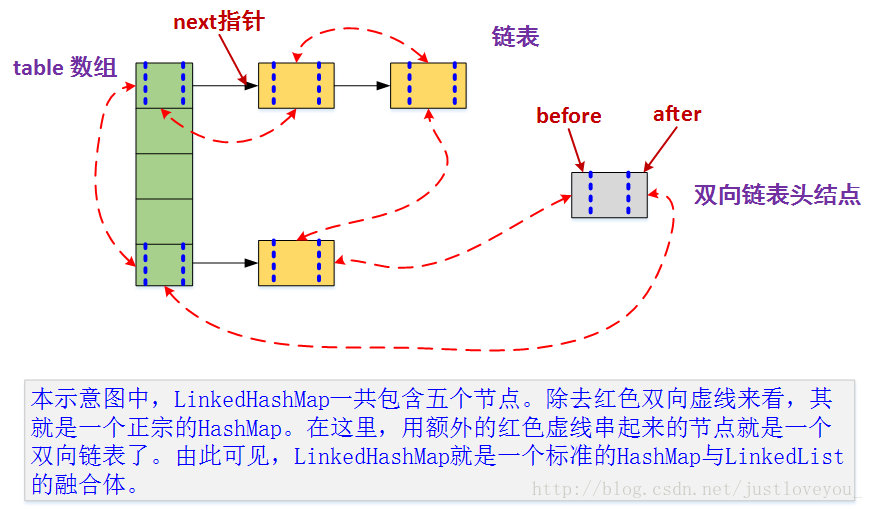

LinkedHashMap

LinkedHashMap继承与hashMap,将HashMap和双向链表合二为一。LinkedHashMap 在不对HashMap做任何改变的基础上,给HashMap的任意两个节点间加了两条连线(before指针和after指针),使这些节点形成一个双向链表。在LinkedHashMapMap中,所有put进来的Entry都保存在HashMap中,但由于它又额外定义了一个以head为头结点的空的双向链表,因此对于每次put进来Entry还会将其插入到双向链表的尾部

TreeMap

底层数据结构是红黑树。 TreeMap是如何保证其迭代输出是有序的呢?其实从宏观上来讲,就相当于树的中序遍历(LDR)

map最高效的遍历方式:

使用 entrySet 遍历 Map 类集合 KV,而不是 keySet 方式进行遍历。 说明:keySet 其实是遍历了 2 次,一次是转为 Iterator 对象,另一次是从hashMap中取出 key 所对应的 value。而entrySet只是遍历了一次就把 key 和 value 都放到了entry中,效率更高。如果是 JDK8,使用 Map.foreach 方法。

Map<String, String> map = new HashMap<>();

map.put("aa", "111");

map.put("bb", "222");

map.put("cc", "333");

for (Map.Entry<String, String> m : map.entrySet()) {

String key = m.getKey();

String value = m.getValue();

System.out.println("key==" + key + " value==" + value);

}

map中key-value是否可以为空

| 集合类 | key | value | superclass | 说明 |

|---|---|---|---|---|

| HashTable | 不可以 | 不可以 | Dictionary | 线程安全 |

| ConcurrentHashMap | 不可以 | 不可以 | AbstractMap | 分段锁技术 |

| TreeMap | 不可以 | 可以 | AbstractMap | 不安全 |

| HashMap | 可以 | 可以 | AbstractMap | 不安全 |

| LinkedHashMap | 可以 | 可以 | AbstractMap | 不安全 |

HashMap 和 Hashtable 的区别

- 线程是否安全: HashMap 是非线程安全的,HashTable 是线程安全的;HashTable 内部的方法基本都经过synchronized 修饰。(如果你要保证线程安全的话就使用 ConcurrentHashMap 吧!);

- 效率: 因为线程安全的问题,HashMap 要比 HashTable 效率高一点。另外,HashTable 基本被淘汰,不要在代码中使用它;

- 对Null key 和Null value的支持: HashMap 中,null 可以作为键,这样的键只有一个,可以有一个或多个键所对应的值为 null。。但是在 HashTable 中 put 进的键值只要有一个 null,直接抛出 NullPointerException。

- 初始容量大小和每次扩充容量大小的不同 : ①创建时如果不指定容量初始值,Hashtable 默认的初始大小为11,之后每次扩充,容量变为原来的2n+1。HashMap 默认的初始化大小为16。之后每次扩充,容量变为原来的2倍。②创建时如果给定了容量初始值,那么 Hashtable 会直接使用你给定的大小,而 HashMap 会将其扩充为2的幂次方大小(HashMap 中的tableSizeFor()方法保证,下面给出了源代码)。也就是说 HashMap 总是使用2的幂作为哈希表的大小,后面会介绍到为什么是2的幂次方。

- 底层数据结构: JDK1.8 以后的 HashMap 在解决哈希冲突时有了较大的变化,当链表长度大于阈值(默认为8)(将链表转换成红黑树前会判断,如果当前数组的长度小于 64,那么会选择先进行数组扩容,而不是转换为红黑树)时,将链表转化为红黑树,以减少搜索时间。Hashtable 没有这样的机制。

HashMap 和 HashSet区别

HashSet 底层就是基于 HashMap 实现的。(HashSet 的源码非常非常少,因为除了 clone() 、writeObject()、readObject()是 HashSet 自己不得不实现之外,其他方法都是直接调用 HashMap 中的方法。

HashMap 的长度为什么是2的幂次方

为了能让 HashMap 存取高效,尽量较少碰撞,也就是要尽量把数据分配均匀。Hash 值的范围值-2147483648到2147483647,前后加起来大概40亿的映射空间,只要哈希函数映射得比较均匀松散,一般应用是很难出现碰撞的。但问题是一个40亿长度的数组,内存是放不下的。所以这个散列值是不能直接拿来用的。用之前还要先做对数组的长度取模运算,得到的余数才能用来要存放的位置也就是对应的数组下标。这个数组下标的计算方法是“ (n - 1) & hash”。(n代表数组长度)。这也就解释了 HashMap 的长度为什么是2的幂次方。

这个算法应该如何设计呢?

我们首先可能会想到采用%取余的操作来实现。但是,重点来了:“取余(%)操作中如果除数是2的幂次则等价于与其除数减一的与(&)操作(也就是说 hash%length==hash&(length-1)的前提是 length 是2的 n 次方;)。” 并且 采用二进制位操作 &,相对于%能够提高运算效率,这就解释了 HashMap 的长度为什么是2的幂次方。

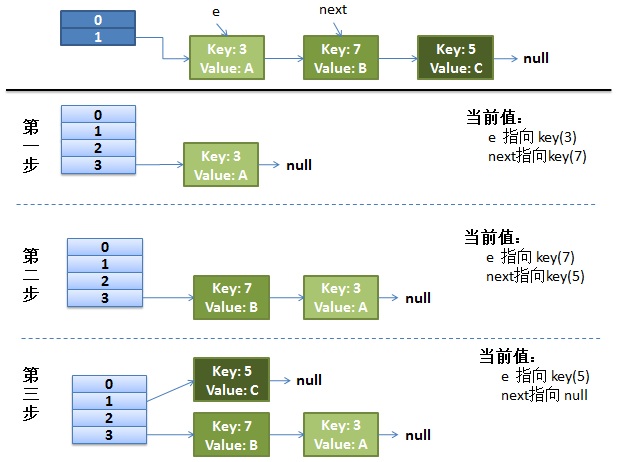

hashmap死循环问题解析

hashmap死循环问题

在淘宝内网里看到同事发了贴说了一个 CPU 被 100% 的线上故障,并且这个事发生了很多次,原因是在 Java 语言在并发情况下使用 HashMap 造成 Race Condition,从而导致死循环。这个事情我 4、5 年前也经历过,本来觉得没什么好写的,因为 Java 的 HashMap 是非线程安全的,所以在并发下必然出现问题。但是,我发现近几年,很多人都经历过这个事(在网上查 “HashMap Infinite Loop” 可以看到很多人都在说这个事)所以,觉得这个是个普遍问题,需要写篇疫苗文章说一下这个事,并且给大家看看一个完美的 “Race Condition” 是怎么形成的。

问题的症状

从前我们的 Java 代码因为一些原因使用了 HashMap 这个东西,但是当时的程序是单线程的,一切都没有问题。后来,我们的程序性能有问题,所以需要变成多线程的,于是,变成多线程后到了线上,发现程序经常占了 100% 的 CPU,查看堆栈,你会发现程序都 Hang 在了 HashMap.get() 这个方法上了,重启程序后问题消失。但是过段时间又会来。而且,这个问题在测试环境里可能很难重现。

我们简单的看一下我们自己的代码,我们就知道 HashMap 被多个线程操作。而 Java 的文档说 HashMap 是非线程安全的,应该用 ConcurrentHashMap。

但是在这里我们可以来研究一下原因。

Hash 表数据结构

我需要简单地说一下 HashMap 这个经典的数据结构。

HashMap 通常会用一个指针数组(假设为 table[])来做分散所有的 key,当一个 key 被加入时,会通过 Hash 算法通过 key 算出这个数组的下标 i,然后就把这个 < key, value> 插到 table[i] 中,如果有两个不同的 key 被算在了同一个 i,那么就叫冲突,又叫碰撞,这样会在 table[i] 上形成一个链表。

我们知道,如果 table[] 的尺寸很小,比如只有 2 个,如果要放进 10 个 keys 的话,那么碰撞非常频繁,于是一个 O(1) 的查找算法,就变成了链表遍历,性能变成了 O(n),这是 Hash 表的缺陷(可参看《Hash Collision DoS 问题》)。

所以,Hash 表的尺寸和容量非常的重要。一般来说,Hash 表这个容器当有数据要插入时,都会检查容量有没有超过设定的 thredhold,如果超过,需要增大 Hash 表的尺寸,但是这样一来,整个 Hash 表里的无素都需要被重算一遍。这叫 rehash,这个成本相当的大。

相信大家对这个基础知识已经很熟悉了。

HashMap 的 rehash 源代码

下面,我们来看一下 Java 的 HashMap 的源代码。

Put 一个 Key,Value 对到 Hash 表中:

public V put(K key, V value)

{

......

//算Hash值

int hash = hash(key.hashCode());

int i = indexFor(hash, table.length);

//如果该key已被插入,则替换掉旧的value (链接操作)

for (Entry<K,V> e = table[i]; e != null; e = e.next) {

Object k;

if (e.hash == hash && ((k = e.key) == key || key.equals(k))) {

V oldValue = e.value;

e.value = value;

e.recordAccess(this);

return oldValue;

}

}

modCount++;

//该key不存在,需要增加一个结点

addEntry(hash, key, value, i);

return null;

}

检查容量是否超标

void addEntry(int hash, K key, V value, int bucketIndex)

{

Entry<K,V> e = table[bucketIndex];

table[bucketIndex] = new Entry<K,V>(hash, key, value, e);

//查看当前的size是否超过了我们设定的阈值threshold,如果超过,需要resize

if (size++ >= threshold)

resize(2 * table.length);

}

新建一个更大尺寸的 hash 表,然后把数据从老的 Hash 表中迁移到新的 Hash 表中。

void resize(int newCapacity)

{

Entry[] oldTable = table;

int oldCapacity = oldTable.length;

......

//创建一个新的Hash Table

Entry[] newTable = new Entry[newCapacity];

//将Old Hash Table上的数据迁移到New Hash Table上

transfer(newTable);

table = newTable;

threshold = (int)(newCapacity * loadFactor);

}

迁移的源代码,注意高亮处:

void transfer(Entry[] newTable)

{

Entry[] src = table;

int newCapacity = newTable.length;

//下面这段代码的意思是:

// 从OldTable里摘一个元素出来,然后放到NewTable中

for (int j = 0; j < src.length; j++) {

Entry<K,V> e = src[j];

if (e != null) {

src[j] = null;

do {

Entry<K,V> next = e.next;

int i = indexFor(e.hash, newCapacity);

e.next = newTable[i];

newTable[i] = e;

e = next;

} while (e != null);

}

}

}

好了,这个代码算是比较正常的。而且没有什么问题。

正常的 ReHash 的过程

画了个图做了个演示。

-

我假设了我们的 hash 算法就是简单的用 key mod 一下表的大小(也就是数组的长度)。

-

最上面的是 old hash 表,其中的 Hash 表的 size=2, 所以 key = 3, 7, 5,在 mod 2 以后都冲突在 table[1] 这里了。

-

接下来的三个步骤是 Hash 表 resize 成 4,然后所有的 <key,value> 重新 rehash 的过程

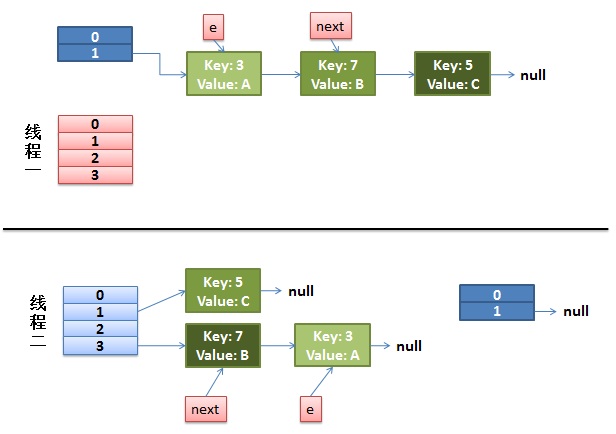

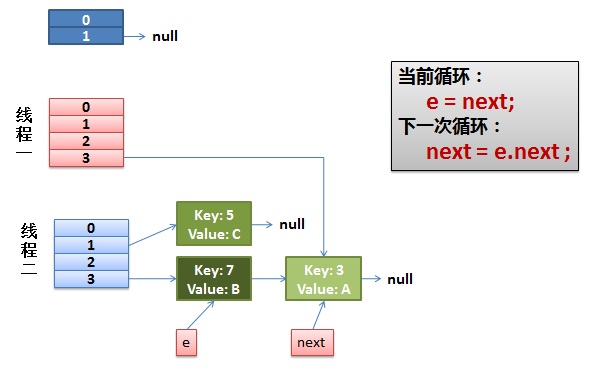

并发下的 Rehash

**1)假设我们有两个线程。**我用红色和浅蓝色标注了一下。

我们再回头看一下我们的 transfer 代码中的这个细节:

do {

Entry<K,V> next = e.next; // <--假设线程一执行到这里就被调度挂起了

int i = indexFor(e.hash, newCapacity);

e.next = newTable[i];

newTable[i] = e;

e = next;

} while (e != null);

而我们的线程二执行完成了。于是我们有下面的这个样子。

注意,因为 Thread1 的 e 指向了 key(3),而 next 指向了 key(7),其在线程二 rehash 后,指向了线程二重组后的链表。我们可以看到链表的顺序被反转后。

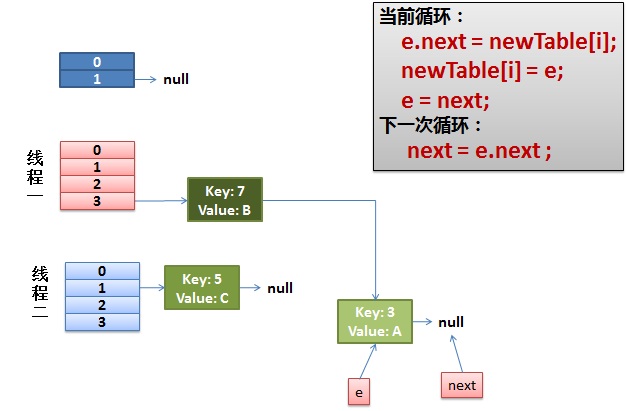

2)线程一被调度回来执行。

- 先是执行 newTalbe[i] = e;

- 然后是 e = next,导致了 e 指向了 key(7),

- 而下一次循环的 next = e.next 导致了 next 指向了 key(3)

3)一切安好。

线程一接着工作。把 key(7) 摘下来,放到 newTable[i] 的第一个,然后把 e 和 next 往下移。

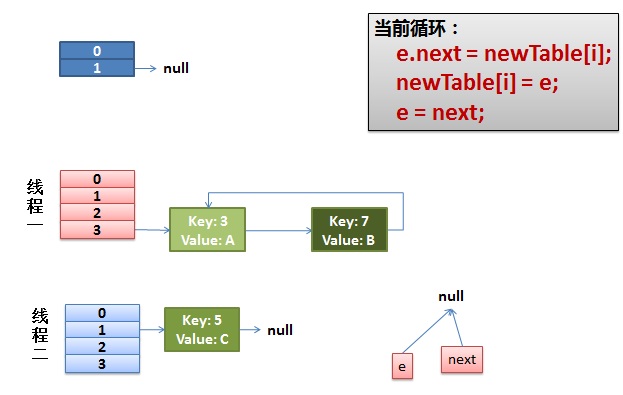

4)环形链接出现。

e.next = newTable[i] 导致 key(3).next 指向了 key(7)

注意:此时的 key(7).next 已经指向了 key(3), 环形链表就这样出现了。

于是,当我们的线程一调用到,HashTable.get(11) 时,悲剧就出现了——Infinite Loop。

其它

有人把这个问题报给了 Sun,不过 Sun 不认为这个是一个问题。因为 HashMap 本来就不支持并发。要并发就用 ConcurrentHashmap

http://bugs.sun.com/bugdatabase/view_bug.do?bug_id=6423457

set

HashSet与TreeSet都是基于Set接口的实现类。其中TreeSet是Set的子接口SortedSet的实现类。Set接口及其子接口、实现类的结构如下所示:

|——SortedSet接口——TreeSet实现类

Set接口——|——HashSet实现类

|——LinkedHashSet实现类

HashSet

HashSet 是 Java 中的一种集合类,它实现了 Set 接口,用于存储不重复的元素。HashSet 的主要特点是它不保证元素的顺序,因此在迭代时无法预测元素的顺序。

以下是 HashSet 的主要特点和实现细节:

-

底层数据结构:

HashSet使用哈希表作为底层数据结构。哈希表是一种用于实现关联数组(Associative Array)的数据结构,它允许快速地插入和查找元素。 -

不允许重复元素:

HashSet不允许存储重复的元素。如果试图将重复元素插入到HashSet中,插入操作将被忽略。 -

无序性: 由于

HashSet使用哈希表,它不保证元素的顺序。因此,在迭代时元素的顺序可能是不确定的。 -

性能:

HashSet提供了较好的性能,具有平均 O(1) 的插入、删除和查找时间复杂度。但在最坏情况下,可能需要 O(n) 的时间复杂度。 -

基于 HashMap:

HashSet实际上是通过继承HashMap类并使用HashMap的键(key)部分来实现的。在HashSet中,元素被当作键,而值则为一个固定的常量。

下面是一个简单的示例,演示了如何使用 HashSet:

import java.util.HashSet;

public class HashSetExample {

public static void main(String[] args) {

HashSet<String> hashSet = new HashSet<>();

// 添加元素到 HashSet

hashSet.add("Apple");

hashSet.add("Banana");

hashSet.add("Orange");

// 打印 HashSet 中的元素(无序)

for (String element : hashSet) {

System.out.println(element);

}

}

}

在上述示例中,元素在 HashSet 中的顺序可能是不确定的。由于 HashSet 不保证元素的顺序,对于需要有序集合的场景,可以考虑使用 LinkedHashSet 或 TreeSet。

LinkedHashSet

LinkedHashSet 是 Java 中的一个集合类,它是 HashSet 的子类,同时也实现了 Set 接口。与 HashSet 不同的是,LinkedHashSet 保留了元素的插入顺序,因此可以按照插入顺序迭代元素。

以下是 LinkedHashSet 的主要特点和实现细节:

-

底层数据结构:

LinkedHashSet的底层数据结构由哈希表和链接列表(Linked List)组成。哈希表用于快速查找元素,链接列表用于维护插入顺序。 -

不允许重复元素: 与

Set接口的特性一致,LinkedHashSet不允许存储重复元素。 -

有序性:

LinkedHashSet保留了元素的插入顺序,因此在迭代时可以按照插入的先后顺序访问元素。 -

性能:

LinkedHashSet提供了与HashSet相似的性能,但由于需要维护插入顺序,相对于简单的哈希表,可能有略微的性能开销。 -

基于

HashSet:LinkedHashSet是通过继承HashSet类并添加链接列表来实现的。

下面是一个简单的示例,演示了如何使用 LinkedHashSet:

import java.util.LinkedHashSet;

public class LinkedHashSetExample {

public static void main(String[] args) {

LinkedHashSet<String> linkedHashSet = new LinkedHashSet<>();

// 添加元素到 LinkedHashSet

linkedHashSet.add("Apple");

linkedHashSet.add("Banana");

linkedHashSet.add("Orange");

// 打印 LinkedHashSet 中的元素(按照插入顺序)

for (String element : linkedHashSet) {

System.out.println(element);

}

}

}

在上述示例中,元素将按照插入顺序("Apple"、"Banana"、"Orange")存储和打印。这种顺序是通过维护链接列表来实现的。与 HashSet 一样,LinkedHashSet 也具有 HashSet 的哈希表特性,即快速查找。

TreeSet

TreeSet 是 Java 中的一个基于红黑树(Red-Black Tree)实现的有序集合类。它实现了 SortedSet 接口,因此存储的元素会按照它们的自然顺序或者通过提供的比较器进行排序。

以下是 TreeSet 的主要特性和实现细节:

-

红黑树:

TreeSet使用红黑树作为底层数据结构。红黑树是一种自平衡的二叉查找树,确保在最坏情况下的基本动态集合操作的时间复杂度为 O(log n)。 -

有序性: 因为使用了红黑树,

TreeSet中的元素是有序的。具体的排序方式取决于元素的自然顺序或提供的比较器。 -

不允许重复元素:

TreeSet不允许存储重复元素。如果试图将重复元素插入到TreeSet中,插入操作将被忽略。 -

迭代顺序: 迭代

TreeSet中的元素将按照它们的升序(自然顺序)或根据提供的比较器的规则进行。 -

基于NavigableMap: 在Java 6之前,

TreeSet是基于TreeMap实现的。从Java 6开始,TreeSet类直接实现了NavigableSet接口,而NavigableSet继承自SortedSet接口。

下面是一个简单的示例,演示了如何使用 TreeSet:

import java.util.TreeSet;

public class TreeSetExample {

public static void main(String[] args) {

TreeSet<Integer> treeSet = new TreeSet<>();

// 添加元素到 TreeSet

treeSet.add(5);

treeSet.add(2);

treeSet.add(8);

treeSet.add(1);

// 打印 TreeSet 中的元素(有序)

for (Integer element : treeSet) {

System.out.println(element);

}

}

}

在上述示例中,元素将按照它们的自然顺序(整数的升序)存储和打印。如果使用自定义对象,确保对象实现了 Comparable 接口或者在创建 TreeSet 时提供了比较器。

LinkedHashSet

LinkedHashSet 是 Java 中的一个集合类,它是 HashSet 的子类,同时也实现了 Set 接口。与 HashSet 不同的是,LinkedHashSet 保留了元素的插入顺序,因此可以按照插入顺序迭代元素。

以下是 LinkedHashSet 的主要特点和实现细节:

-

底层数据结构:

LinkedHashSet的底层数据结构由哈希表和链接列表(Linked List)组成。哈希表用于快速查找元素,链接列表用于维护插入顺序。 -

不允许重复元素: 与

Set接口的特性一致,LinkedHashSet不允许存储重复元素。 -

有序性:

LinkedHashSet保留了元素的插入顺序,因此在迭代时可以按照插入的先后顺序访问元素。 -

性能:

LinkedHashSet提供了与HashSet相似的性能,但由于需要维护插入顺序,相对于简单的哈希表,可能有略微的性能开销。 -

基于

HashSet:LinkedHashSet是通过继承HashSet类并添加链接列表来实现的。

下面是一个简单的示例,演示了如何使用 LinkedHashSet:

import java.util.LinkedHashSet;

public class LinkedHashSetExample {

public static void main(String[] args) {

LinkedHashSet<String> linkedHashSet = new LinkedHashSet<>();

// 添加元素到 LinkedHashSet

linkedHashSet.add("Apple");

linkedHashSet.add("Banana");

linkedHashSet.add("Orange");

// 打印 LinkedHashSet 中的元素(按照插入顺序)

for (String element : linkedHashSet) {

System.out.println(element);

}

}

}

在上述示例中,元素将按照插入顺序("Apple"、"Banana"、"Orange")存储和打印。这种顺序是通过维护链接列表来实现的。与 HashSet 一样,LinkedHashSet 也具有 HashSet 的哈希表特性,即快速查找。

HashMap 和 HashSet区别

如果你看过 HashSet 源码的话就应该知道:HashSet 底层就是基于 HashMap 实现的。(HashSet 的源码非常非常少,因为除了 clone()、writeObject()、readObject()是 HashSet 自己不得不实现之外,其他方法都是直接调用 HashMap 中的方法。

HashMap HashSet 实现了Map接口 实现Set接口 存储键值对 仅存储对象 调用 put()向map中添加元素 调用 add()方法向Set中添加元素 HashMap使用键(Key)计算Hashcode HashSet使用成员对象来计算hashcode值,对于两个对象来说hashcode可能相同,所以equals()方法用来判断对象的相等性,

queue

队列是限制结点插入操作固定在一端进行,而结点的删除操作固定在另一端进行的线性表. 队列犹如一个两端开口的管道.允许插入的一端称为队头,允许删除的一端称为队尾.队头和队尾各用一个”指针”指示,称为队头指针和队尾指针.不含任何结点的队列称为”空队列”.队列的特点是结点在队列中的排队次序和出队次序按进队时间先后确定,即先进队者先出队.因此,队列又称先进先出表.简称FIFO(first in first out)表.

java中的queue

Java 提供的线程安全的 Queue 可以分为阻塞队列和非阻塞队列,其中阻塞队列的典型例子是 BlockingQueue,非阻塞队列的典型例子是 ConcurrentLinkedQueue,在实际应用中要根据实际需要选用阻塞队列或者非阻塞队列。 阻塞队列可以通过加锁来实现,非阻塞队列可以通过 CAS 操作实现。

ConcurrentLinkedQueue

从名字可以看出,ConcurrentLinkedQueue这个队列使用链表作为其数据结构.ConcurrentLinkedQueue 应该算是在高并发环境中性能最好的队列了。它之所有能有很好的性能,是因为其内部复杂的实现。

ConcurrentLinkedQueue 内部代码我们就不分析了,大家知道 ConcurrentLinkedQueue 主要使用 CAS 非阻塞算法来实现线程安全就好了。

AQS(AbstractQueuedSynchronizer)

类如其名,抽象的队列式的同步器,AQS定义了一套多线程访问共享资源的同步器框架,许多同步类实现都依赖于它,如常用的ReentrantLock/Semaphore/CountDownLatch...。

ArrayBlockingQueue

ArrayBlockingQueue 是 BlockingQueue 接口的有界队列实现类,底层采用数组来实现。ArrayBlockingQueue 一旦创建,容量不能改变。其并发控制采用可重入锁来控制,不管是插入操作还是读取操作,都需要获取到锁才能进行操作。当队列容量满时,尝试将元素放入队列将导致操作阻塞;尝试从一个空队列中取一个元素也会同样阻塞。

ArrayBlockingQueue 默认情况下不能保证线程访问队列的公平性,所谓公平性是指严格按照线程等待的绝对时间顺序,即最先等待的线程能够最先访问到 ArrayBlockingQueue。而非公平性则是指访问 ArrayBlockingQueue 的顺序不是遵守严格的时间顺序,有可能存在,当 ArrayBlockingQueue 可以被访问时,长时间阻塞的线程依然无法访问到 ArrayBlockingQueue。如果保证公平性,通常会降低吞吐量

ArrayBlockingQueue原理分析

ArrayBlockingQueue 共有以下几个属性:

// 用于存放元素的数组

final Object[] items;

// 下一次读取操作的位置

int takeIndex;

// 下一次写入操作的位置

int putIndex;

// 队列中的元素数量

int count;

// 以下几个就是控制并发用的同步器

final ReentrantLock lock;

private final Condition notEmpty;

private final Condition notFull;

我们用个示意图来描述其同步机制:

ArrayBlockingQueue 实现并发同步的原理就是,读操作和写操作都需要获取到 AQS 独占锁才能进行操作。如果队列为空,这个时候读操作的线程进入到读线程队列排队,等待写线程写入新的元素,然后唤醒读线程队列的第一个等待线程。如果队列已满,这个时候写操作的线程进入到写线程队列排队,等待读线程将队列元素移除腾出空间,然后唤醒写线程队列的第一个等待线程

LinkedBlockingQueue

LinkedBlockingQueue 底层基于单向链表实现的阻塞队列,可以当做无界队列也可以当做有界队列来使用,同样满足 FIFO 的特性,与 ArrayBlockingQueue 相比起来具有更高的吞吐量,为了防止 LinkedBlockingQueue 容量迅速增,损耗大量内存。通常在创建 LinkedBlockingQueue 对象时,会指定其大小,如果未指定,容量等于 Integer.MAX_VALUE。

PriorityBlockingQueue

参考文章

vector

list的线程安全版本。add和get都是同步方法,效率比较低。不建议使用。

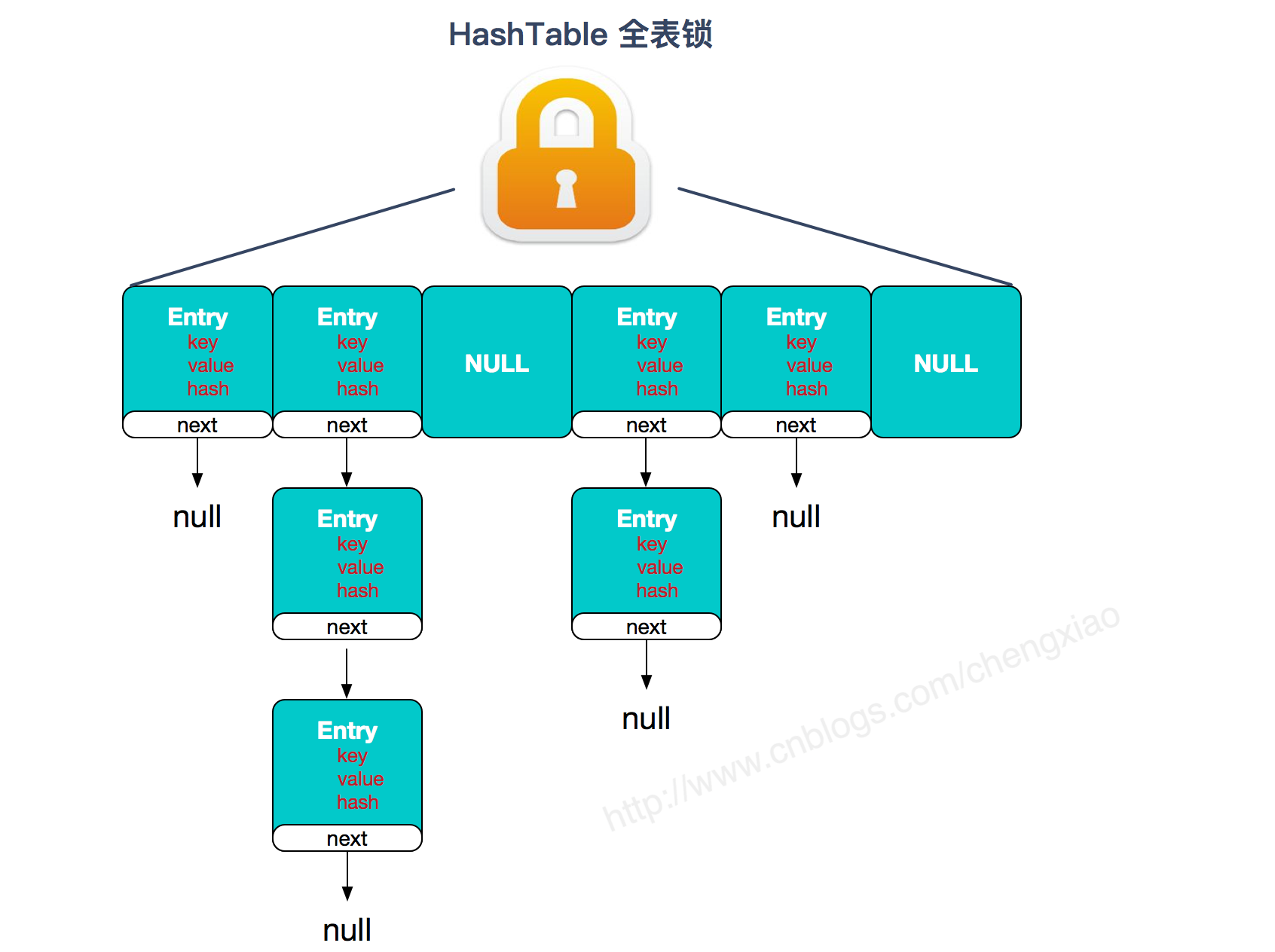

ConcurrentHashMap 和 Hashtable 的区别

ConcurrentHashMap 和 Hashtable 的区别主要体现在实现线程安全的方式上不同。

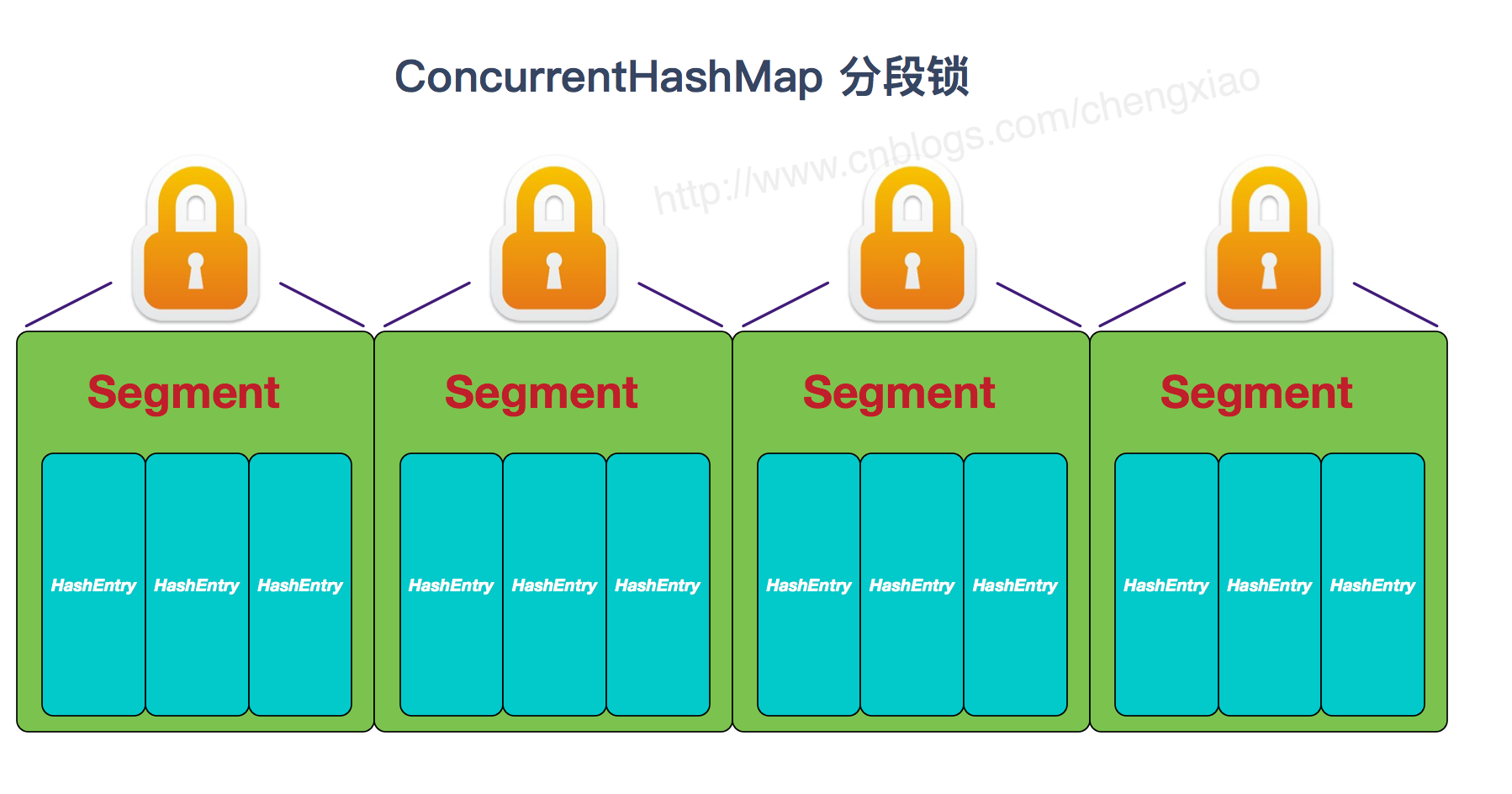

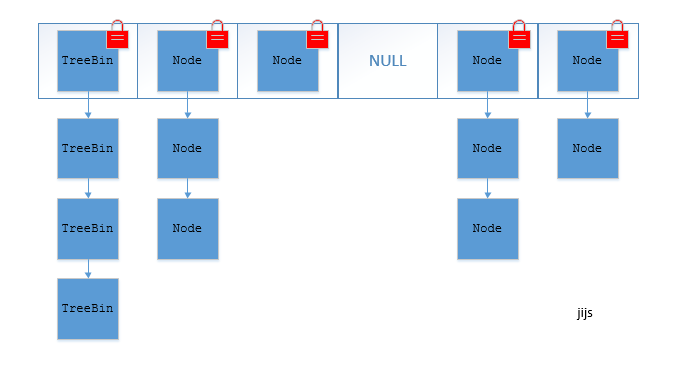

1、底层数据结构: JDK1.7的 ConcurrentHashMap 底层采用 分段的数组+链表 实现,JDK1.8 采用的数据结构跟HashMap1.8的结构一样,数组+链表/红黑二叉树。Hashtable 和 JDK1.8 之前的 HashMap 的底层数据结构类似都是采用 数组+链表 的形式,数组是 HashMap 的主体,链表则是主要为了解决哈希冲突而存在的;

2、实现线程安全的方式(重要): ① 在JDK1.7的时候,ConcurrentHashMap(分段锁) 对整个桶数组进行了分割分段(Segment),每一把锁只锁容器其中一部分数据,多线程访问容器里不同数据段的数据,就不会存在锁竞争,提高并发访问率。 到了 JDK1.8 的时候已经摒弃了Segment的概念,而是直接用 Node 数组+链表+红黑树的数据结构来实现,并发控制使用 synchronized 和 CAS 来操作。(JDK1.6以后 对 synchronized锁做了很多优化) 整个看起来就像是优化过且线程安全的 HashMap,虽然在JDK1.8中还能看到 Segment 的数据结构,但是已经简化了属性,只是为了兼容旧版本;② Hashtable(同一把锁) :使用 synchronized 来保证线程安全,效率非常低下。当一个线程访问同步方法时,其他线程也访问同步方法,可能会进入阻塞或轮询状态,如使用 put 添加元素,另一个线程不能使用 put 添加元素,也不能使用 get,竞争会越来越激烈效率越低。

两者的对比图:

copyOnWriteList

CopyOnWriteArrayList 类的所有可变操作(add,set 等等)都是通过创建底层数组的新副本来实现的。当 List 需要被修改的时候,我并不修改原有内容,而是对原有数据进行一次复制,将修改的内容写入副本。写完之后,再将修改完的副本替换原来的数据,这样就可以保证写操作不会影响读操作了。

从 CopyOnWriteArrayList 的名字就能看出CopyOnWriteArrayList 是满足CopyOnWrite 的 ArrayList,所谓CopyOnWrite 也就是说:在计算机,如果你想要对一块内存进行修改时,我们不在原有内存块中进行写操作,而是将内存拷贝一份,在新的内存中进行写操作,写完之后呢,就将指向原来内存指针指向新的内存,原来的内存就可以被回收掉了。

CopyOnWriteArrayList 读取操作的实现

读取操作没有任何同步控制和锁操作,理由就是内部数组 array 不会发生修改,只会被另外一个 array 替换,因此可以保证数据安全。

/** The array, accessed only via getArray/setArray. */

private transient volatile Object[] array;

public E get(int index) {

return get(getArray(), index);

}

@SuppressWarnings("unchecked")

private E get(Object[] a, int index) {

return (E) a[index];

}

final Object[] getArray() {

return array;

}

CopyOnWriteArrayList 写入操作的实现

CopyOnWriteArrayList 写入操作 add() 方法在添加集合的时候加了锁,保证了同步,避免了多线程写的时候会 copy 出多个副本出来。

/**

* Appends the specified element to the end of this list.

*

* @param e element to be appended to this list

* @return {@code true} (as specified by {@link Collection#add})

*/

public boolean add(E e) {

final ReentrantLock lock = this.lock;

lock.lock();//加锁

try {

Object[] elements = getArray();

int len = elements.length;

Object[] newElements = Arrays.copyOf(elements, len + 1);//拷贝新数组

newElements[len] = e;

setArray(newElements);

return true;

} finally {

lock.unlock();//释放锁

}

}

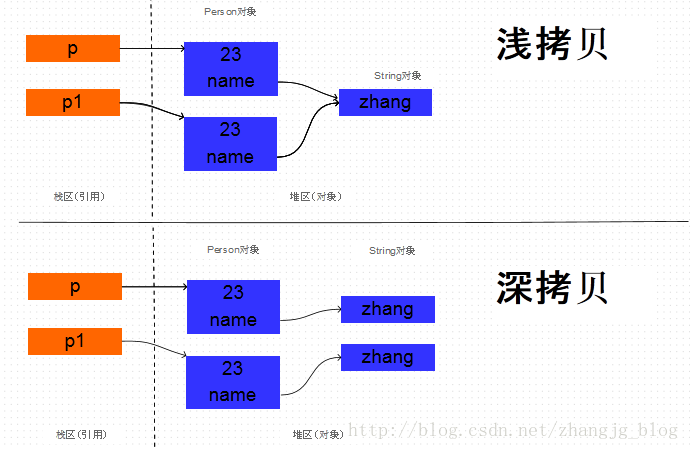

深copy和浅copy

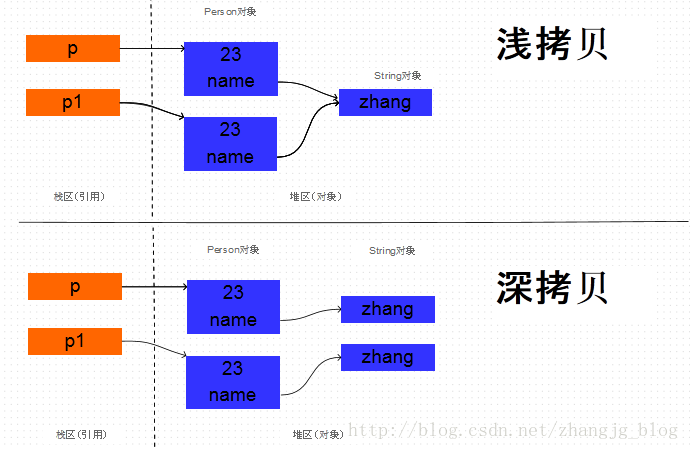

浅copy只是复制对象的引用,一旦引用的对象发生改变,copy的对象也会改变。本质上是对象地址的引用。

深copy是从新构造一个对象,对象的所有字段都和源对象一致。但是对象的地址的不一样的,改变源对象不会有影响。

clone的使用

覆盖Object中的clone方法, 实现浅拷贝。 实现Cloneable接口。假如这个对象引用了其它的对象,引用对象也必须实现Cloneable接口。

深拷贝和彻底深拷贝,在创建不可变对象时,可能对程序有着微妙的影响,可能会决定我们创建的不可变对象是不是真的不可变。clone的一个重要的应用也是用于不可变对象的创建。

序列化和反序列化

Java序列化是指把Java对象保存为二进制字节码的过程,Java反序列化是指把二进制码重新转换成Java对象的过程。

那么为什么需要序列化呢?

第一种情况是:一般情况下Java对象的声明周期都比Java虚拟机的要短,实际应用中我们希望在JVM停止运行之后能够持久化指定的对象,这时候就需要把对象进行序列化之后保存。

第二种情况是:需要把Java对象通过网络进行传输的时候。因为数据只能够以二进制的形式在网络中进行传输,因此当把对象通过网络发送出去之前需要先序列化成二进制数据,在接收端读到二进制数据之后反序列化成Java对象

反射

JAVA反射机制是在运行状态中,对于任意一个类,都能够知道这个类的所有属性和方法;对于任意一个对象,都能够调用它的任意一个方法和属性;这种动态获取的信息以及动态调用对象的方法的功能称为java语言的反射机制。

//1.加载Class对象

Class clazz = Class.forName("fanshe.Student");

//2.获取所有公有构造方法

System.out.println("**********************所有公有构造方法*********************************");

Constructor[] conArray = clazz.getConstructors();

for(Constructor c : conArray){

System.out.println(c);

}

System.out.println("******所有的构造方法(包括:私有、受保护、默认、公有)***");

conArray = clazz.getDeclaredConstructors();

for(Constructor c : conArray){

System.out.println(c);

}

System.out.println("*********获取公有、无参的构造方法*****");

Constructor con = clazz.getConstructor(null);

//1>、因为是无参的构造方法所以类型是一个null,不写也可以:这里需要的是一个参数的类型,切记是类型

//2>、返回的是描述这个无参构造函数的类对象。

System.out.println("con = " + con);

//调用构造方法

Object obj = con.newInstance();

System.out.println("***********获取私有构造方法,并调用***");

con = clazz.getDeclaredConstructor(char.class);

System.out.println(con);

//调用构造方法

con.setAccessible(true);//暴力访问(忽略掉访问修饰符)

obj = con.newInstance('男');

内省

在计算机科学中,内省是指计算机程序在运行时(Run time)检查对象(Object)类型的一种能力,通常也可以称作运行时类型检查。 不应该将内省和反射混淆。相对于内省,反射更进一步,是指计算机程序在运行时(Run time)可以访问、检测和修改它本身状态或行为的一种能力。

内省和反射有什么区别?

反射是在运行状态把Java类中的各种成分映射成相应的Java类,可以动态的获取所有的属性以及动态调用任意一个方法,强调的是运行状态。

内省(IntroSpector)是Java 语言对 Bean 类属性、事件的一种缺省处理方法。 JavaBean是一种特殊的类,主要用于传递数据信息,这种类中的方法主要用于访问私有的字段,且方法名符合某种命名规则。如果在两个模块之间传递信息,可以将信息封装进JavaBean中,这种对象称为“值对象”(Value Object),或“VO”。方法比较少。这些信息储存在类的私有变量中,通过set()、get()获得。内省机制是通过反射来实现的,BeanInfo用来暴露一个bean的属性、方法和事件,以后我们就可以操纵该JavaBean的属性。

泛型

泛型,即“参数化类型”。一提到参数,最熟悉的就是定义方法时有形参,然后调用此方法时传递实参。那么参数化类型怎么理解呢?顾名思义,就是将类型由原来的具体的类型参数化,类似于方法中的变量参数,此时类型也定义成参数形式(可以称之为类型形参),然后在使用/调用时传入具体的类型(类型实参)。

泛型的本质是为了参数化类型(在不创建新的类型的情况下,通过泛型指定的不同类型来控制形参具体限制的类型)。也就是说在泛型使用过程中,操作的数据类型被指定为一个参数,这种参数类型可以用在类、接口和方法中,分别被称为泛型类、泛型接口、泛型方法。

泛型只在编译阶段有效。看下面的代码:

List<String> stringArrayList = new ArrayList<String>();

List<Integer> integerArrayList = new ArrayList<Integer>();

Class classStringArrayList = stringArrayList.getClass();

Class classIntegerArrayList = integerArrayList.getClass();

if(classStringArrayList.equals(classIntegerArrayList)){

Log.d("泛型测试","类型相同");

}

输出结果:D/泛型测试: 类型相同。

通过上面的例子可以证明,在编译之后程序会采取去泛型化的措施。也就是说Java中的泛型,只在编译阶段有效。在编译过程中,正确检验泛型结果后,会将泛型的相关信息擦出,并且在对象进入和离开方法的边界处添加类型检查和类型转换的方法。也就是说,泛型信息不会进入到运行时阶段

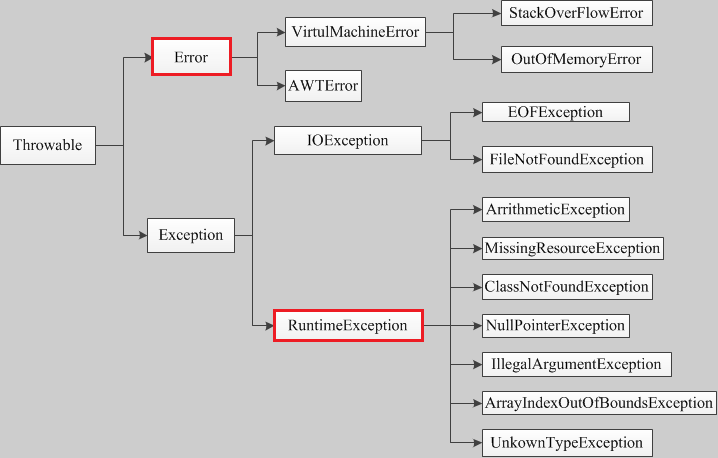

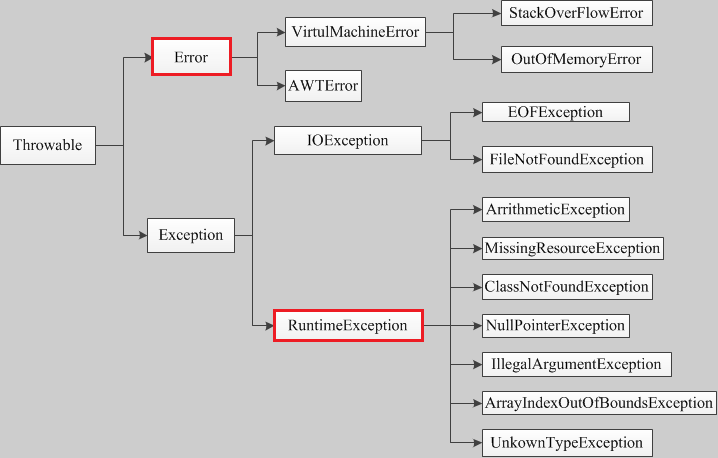

异常处理

程序运行时,发生的不被期望的事件,它阻止了程序按照程序员的预期正常执行,这就是异常。异常发生时,是任程序自生自灭,立刻退出终止,还是输出错误给用户?或者用C语言风格:用函数返回值作为执行状态?。

Java提供了更加优秀的解决办法:异常处理机制。

异常处理机制能让程序在异常发生时,按照代码的预先设定的异常处理逻辑,针对性地处理异常,让程序尽最大可能恢复正常并继续执行,且保持代码的清晰。 Java中的异常可以是函数中的语句执行时引发的,也可以是程序员通过throw 语句手动抛出的,只要在Java程序中产生了异常,就会用一个对应类型的异常对象来封装异常,JRE就会试图寻找异常处理程序来处理异常。

Throwable类是Java异常类型的顶层父类,一个对象只有是 Throwable 类的(直接或者间接)实例,他才是一个异常对象,才能被异常处理机制识别。JDK中内建了一些常用的异常类,我们也可以自定义异常。

深copy和浅copy

浅copy只是复制对象的引用,一旦引用的对象发生改变,copy的对象也会改变。本质上是对象地址的引用。

深copy是从新构造一个对象,对象的所有字段都和源对象一致。但是对象的地址的不一样的,改变源对象不会有影响。

clone的使用

覆盖Object中的clone方法, 实现浅拷贝。 实现Cloneable接口。假如这个对象引用了其它的对象,引用对象也必须实现Cloneable接口。

深拷贝和彻底深拷贝,在创建不可变对象时,可能对程序有着微妙的影响,可能会决定我们创建的不可变对象是不是真的不可变。clone的一个重要的应用也是用于不可变对象的创建。

序列化和反序列化

Java序列化是指把Java对象保存为二进制字节码的过程,Java反序列化是指把二进制码重新转换成Java对象的过程。

那么为什么需要序列化呢?

第一种情况是:一般情况下Java对象的声明周期都比Java虚拟机的要短,实际应用中我们希望在JVM停止运行之后能够持久化指定的对象,这时候就需要把对象进行序列化之后保存。

第二种情况是:需要把Java对象通过网络进行传输的时候。因为数据只能够以二进制的形式在网络中进行传输,因此当把对象通过网络发送出去之前需要先序列化成二进制数据,在接收端读到二进制数据之后反序列化成Java对象

反射

JAVA反射机制是在运行状态中,对于任意一个类,都能够知道这个类的所有属性和方法;对于任意一个对象,都能够调用它的任意一个方法和属性;这种动态获取的信息以及动态调用对象的方法的功能称为java语言的反射机制。

//1.加载Class对象

Class clazz = Class.forName("fanshe.Student");

//2.获取所有公有构造方法

System.out.println("**********************所有公有构造方法*********************************");

Constructor[] conArray = clazz.getConstructors();

for(Constructor c : conArray){

System.out.println(c);

}

System.out.println("******所有的构造方法(包括:私有、受保护、默认、公有)***");

conArray = clazz.getDeclaredConstructors();

for(Constructor c : conArray){

System.out.println(c);

}

System.out.println("*********获取公有、无参的构造方法*****");

Constructor con = clazz.getConstructor(null);

//1>、因为是无参的构造方法所以类型是一个null,不写也可以:这里需要的是一个参数的类型,切记是类型

//2>、返回的是描述这个无参构造函数的类对象。

System.out.println("con = " + con);

//调用构造方法

Object obj = con.newInstance();

System.out.println("***********获取私有构造方法,并调用***");

con = clazz.getDeclaredConstructor(char.class);

System.out.println(con);

//调用构造方法

con.setAccessible(true);//暴力访问(忽略掉访问修饰符)

obj = con.newInstance('男');

内省

在计算机科学中,内省是指计算机程序在运行时(Run time)检查对象(Object)类型的一种能力,通常也可以称作运行时类型检查。 不应该将内省和反射混淆。相对于内省,反射更进一步,是指计算机程序在运行时(Run time)可以访问、检测和修改它本身状态或行为的一种能力。

内省和反射有什么区别?

反射是在运行状态把Java类中的各种成分映射成相应的Java类,可以动态的获取所有的属性以及动态调用任意一个方法,强调的是运行状态。

内省(IntroSpector)是Java 语言对 Bean 类属性、事件的一种缺省处理方法。 JavaBean是一种特殊的类,主要用于传递数据信息,这种类中的方法主要用于访问私有的字段,且方法名符合某种命名规则。如果在两个模块之间传递信息,可以将信息封装进JavaBean中,这种对象称为“值对象”(Value Object),或“VO”。方法比较少。这些信息储存在类的私有变量中,通过set()、get()获得。内省机制是通过反射来实现的,BeanInfo用来暴露一个bean的属性、方法和事件,以后我们就可以操纵该JavaBean的属性。

泛型

泛型,即“参数化类型”。一提到参数,最熟悉的就是定义方法时有形参,然后调用此方法时传递实参。那么参数化类型怎么理解呢?顾名思义,就是将类型由原来的具体的类型参数化,类似于方法中的变量参数,此时类型也定义成参数形式(可以称之为类型形参),然后在使用/调用时传入具体的类型(类型实参)。

泛型的本质是为了参数化类型(在不创建新的类型的情况下,通过泛型指定的不同类型来控制形参具体限制的类型)。也就是说在泛型使用过程中,操作的数据类型被指定为一个参数,这种参数类型可以用在类、接口和方法中,分别被称为泛型类、泛型接口、泛型方法。

泛型只在编译阶段有效。看下面的代码:

List<String> stringArrayList = new ArrayList<String>();

List<Integer> integerArrayList = new ArrayList<Integer>();

Class classStringArrayList = stringArrayList.getClass();

Class classIntegerArrayList = integerArrayList.getClass();

if(classStringArrayList.equals(classIntegerArrayList)){

Log.d("泛型测试","类型相同");

}

输出结果:D/泛型测试: 类型相同。

通过上面的例子可以证明,在编译之后程序会采取去泛型化的措施。也就是说Java中的泛型,只在编译阶段有效。在编译过程中,正确检验泛型结果后,会将泛型的相关信息擦出,并且在对象进入和离开方法的边界处添加类型检查和类型转换的方法。也就是说,泛型信息不会进入到运行时阶段

异常处理

程序运行时,发生的不被期望的事件,它阻止了程序按照程序员的预期正常执行,这就是异常。异常发生时,是任程序自生自灭,立刻退出终止,还是输出错误给用户?或者用C语言风格:用函数返回值作为执行状态?。

Java提供了更加优秀的解决办法:异常处理机制。

异常处理机制能让程序在异常发生时,按照代码的预先设定的异常处理逻辑,针对性地处理异常,让程序尽最大可能恢复正常并继续执行,且保持代码的清晰。 Java中的异常可以是函数中的语句执行时引发的,也可以是程序员通过throw 语句手动抛出的,只要在Java程序中产生了异常,就会用一个对应类型的异常对象来封装异常,JRE就会试图寻找异常处理程序来处理异常。

Throwable类是Java异常类型的顶层父类,一个对象只有是 Throwable 类的(直接或者间接)实例,他才是一个异常对象,才能被异常处理机制识别。JDK中内建了一些常用的异常类,我们也可以自定义异常。

编程语言

1、java为什么比c++慢?

a、执行层面,java语言需要把java翻译成字节码,由jvm虚拟机执行,jvm虚拟机再把字节码翻译为汇编再执行,中间多了一层jvm,对性能有影响。 b、内存管理方面:java无需进行手动内存管理,但是jvm垃圾回收是会暂停用户线程的,也会对性能有影响,而且gc线程本身也对cpu和内存资源有影响。

2、java泛型是如何实现的,和golang进行对比?

Java 和 Go 语言泛型的实现原理相似,都是基于类型擦除和类型约束。但是,Java 和 Go 语言在泛型实现的具体方式上存在一些区别,主要体现在以下几个方面:

-

类型擦除的方式不同:

- Java 语言在编译时会进行类型擦除,将泛型类型擦除为它们的基类或接口。在运行时,Java 语言使用的是擦除后的类型信息。

- Go 语言在编译时也会进行类型擦除,但是它使用的是类型约束来限制泛型类型参数的取值范围,而不是像 Java 语言那样将泛型类型擦除为它们的基类或接口。在运行时,Go 语言使用的是类型约束来保证泛型代码可以与具体类型进行互操作。

-

对泛型类型的限制不同:

- Java 语言对泛型类型的限制比较宽松,只需要满足类型擦除后的类型信息与泛型代码中的类型约束相匹配即可。

- Go 语言对泛型类型的限制比较严格,需要在编译时通过类型约束来限制泛型类型参数的取值范围。

-

泛型数组的支持不同:

- Java 语言支持泛型数组,可以使用泛型类型参数来创建数组。

- Go 语言不支持泛型数组,需要使用具体类型来创建数组。

总的来说,虽然 Java 和 Go 语言泛型的实现原理相似,但是在具体实现上存在一些差异。Java 语言更加灵活,对泛型类型的限制比较宽松;而 Go 语言更加严格,需要在编译时通过类型约束来限制泛型类型参数的取值范围。

3、java反射的原理,以及优缺点?

4、zgc和g1的对比?

java多线程

线程和进程

-

概念

- 进程是具有一定独立功能的程序关于某个数据集合上的一次运行活动,进程是系统进行资源分配和调度的一个独立单位。

- 线程是进程的一个实体,是CPU调度和分派的基本单位,它是比进程更小的能独立运行的基本单位.

-

区别

- 一个程序至少有一个进程,一个进程至少有一个线程.

- 线程的划分尺度小于进程,线程必进程更轻量级,使得多线程程序的并发性高。

- 进程在执行过程中拥有独立的内存单元,而多个线程共享内存,从而极大地提高了程序的运行效率。

- 线程在执行过程中与进程还是有区别的。每个独立的线程有一个程序运行的入口、顺序执行序列和程序的出口。但是线程不能够独立执行,必须依存在应用程序中,由应用程序提供多个线程执行控制。

- 从逻辑角度来看,多线程的意义在于一个应用程序中,有多个执行部分可以同时执行。但操作系统并没有将多个线程看做多个独立的应用,来实现进程的调度和管理以及资源分配。这就是进程和线程的重要区别。

线程和协程的区别

- 协程是单线程,多个协程在一个线程里调度

- 协程由应用层调度,不需要cpu内核调度

- 协程内存暂用更少,一个协程只需要几十k,而线程需要8m或者更多

什么时候使用多线程?什么时候使用单线程?

单线程性能并不一定低,单线程没有锁和线程切换,资源占用少。 当线程切换和创建的时间原因小于代码执行时间时,多线程能发挥大作用。

java多线程的缺点?

- 代码复杂

- 加锁操作严重影响性能

线程的实现方式?java线程是如何实现的?

实现线程主要有3种方式:使用内核线程实现、使用用户线程实现、使用用户线程加轻量级进程混合实现。

1、内核线程实现

内核线程(Kernel-Level Thread,KLT)就是直接由操作系统内核(Kernel,下称内核)支持的线程, 这种线程由内核来完成线程切换,内核通过操纵调度器(Scheduler)对线程进行调度,并负责将线程的 任务映射到各个处理器上。

首先,由于是基于内 核线程实现的,所以各种线程操作,如创建、析构及同步,都需要进行系统调用。而系统调用的代价相 对较高,需要在用户态(User Mode)和内核态(Kernel Mode)中来回切换。其次,每个轻量级进程都 需要有一个内核线程的支持,因此轻量级进程要消耗一定的内核资源(如内核线程的栈空间)

2、用户线程实现

使用用户线程的优势在于不需要系统内核支援,劣势也在于没有系统内核的支援,所有的线程操作 都需要用户程序自己处理。线程的创建、切换和调度都是需要考虑的问题。

3、用户线程加轻量级进程混合实现

线程除了依赖内核线程实现和完全由用户程序自己实现之外,还有一种将内核线程与用户线程一起 使用的实现方式。在这种混合实现下,既存在用户线程,也存在轻量级进程。用户线程还是完全建立在 用户空间中,因此用户线程的创建、切换、析构等操作依然廉价,并且可以支持大规模的用户线程并发。而操作系统提供支持的轻量级进程则作为用户线程和内核线程之间的桥梁,这样可以使用内核提供的线程调度功能及处理器映射,并且用户线程的系统调用要通过轻量级线程来完成,大大降低了整个进 程被完全阻塞的风险。在这种混合模式中,用户线程与轻量级进程的数量比是不定的,即为N:M的关系,就是多对多的线程模型

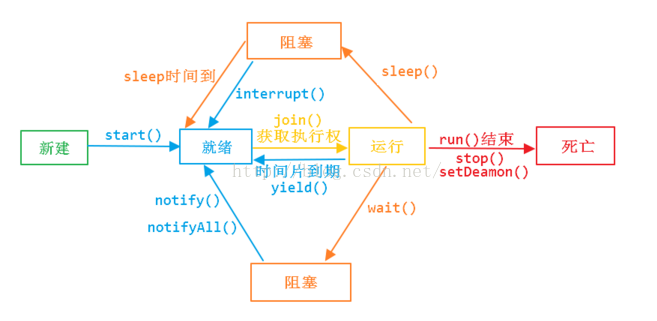

线程的生命周期

- 新建状态

- 就绪状态

- 运行状态

- 阻塞状态

- 死亡状态

如何启动和销毁线程

- 使用start方法启动线程

- 销毁线程有三种

- 使用变量标志

- 使用stop(不推荐使用)

- 使用interrupt

如何判断线程的状态

- Thread.isAlive()

interrupt、interrupted 、isInterrupted 区别

- interrupt()进行线程中断,调用该方法的线程的状态为将被置为"中断"状态

- interrupted 是作用于当前线程,会清除中断状态

- isInterrupted 是作用于调用该方法的线程对象所对应的线程

多线程的实现方式

- 继承Thread类

- 实现Runnable接口

同步的方式

- syncronized方法

- lock

死锁

死锁是指多个进程循环等待它方占有的资源而无限期地僵持下去的局面。

实现生产者消费者

public class Restaurant {

Meal meal;

WaitPerson waitPerson = new WaitPerson(this);

ExecutorService exec = Executors.newCachedThreadPool();

Chef chef = new Chef(this);

public Restaurant(){

exec.execute(waitPerson);

exec.execute(chef);

}

public static void main(String[] args) {

new Restaurant();

}

}

class Meal{

private final int orderNum;

public Meal(int orderNum){

this.orderNum = orderNum;

}

@Override

public String toString() {

return "Meal "+ orderNum;

}

}

class WaitPerson implements Runnable{

private Restaurant restaurant;

public WaitPerson(Restaurant r){

this.restaurant = r;

}

@Override

public void run() {

try {

while(!Thread.interrupted()){

synchronized (this){

while (restaurant.meal==null){

wait();

}

System.out.println("waitPerson get"+ restaurant.meal);

}

synchronized (restaurant.chef){

restaurant.meal = null;

restaurant.chef.notifyAll();

}

}

}catch (InterruptedException e){

System.out.println(" waitPerson interrupted");

}

}

}

class Chef implements Runnable{

private Restaurant restaurant;

private int count = 0;

public Chef(Restaurant r){

this.restaurant = r;

}

@Override

public void run() {

try {

while(!Thread.interrupted()){

synchronized (this){

while (restaurant.meal!=null){

wait();

}

}

if(++count == 10){

System.out.println("out of food, closing");

restaurant.exec.shutdownNow();

}

System.out.println("Order up!");

synchronized (restaurant.waitPerson){

restaurant.meal = new Meal(count);

restaurant.waitPerson.notifyAll();

}

TimeUnit.MILLISECONDS.sleep(100);

}

}catch (InterruptedException e){

System.out.println(" chef interrupted");

}

}

}

CAS操作与问题

CAS操作是jdk新的cpu指令,

threadLocal

原理

线程

优缺点

使用场景

上下文传参,线程私有变量,

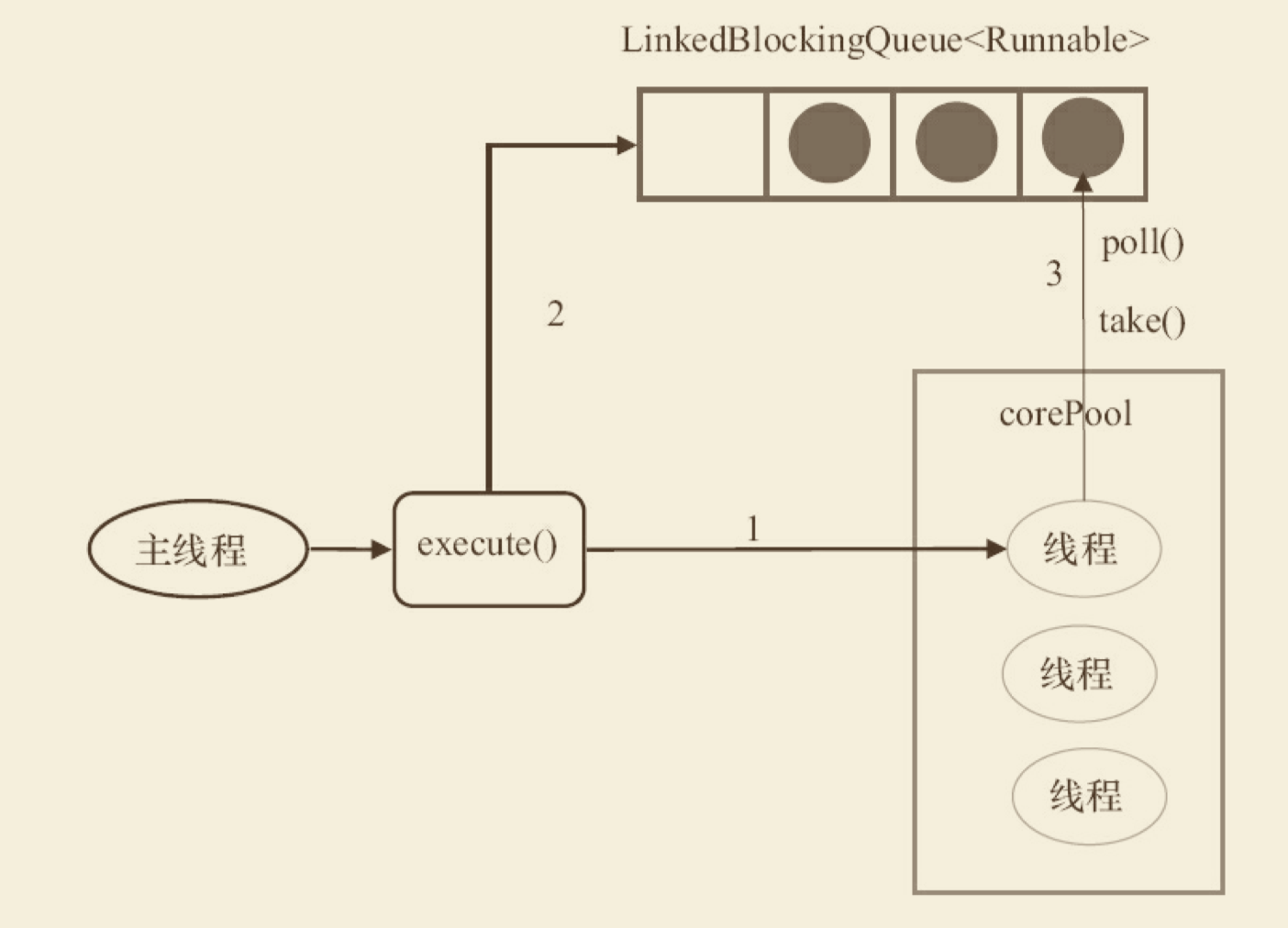

线程池的参数和原理

-

corePoolSize:线程池中的核心线程数,当提交一个任务时,线程池创建一个新线程执行任务,直到当前线程数等于corePoolSize; 如果当前线程数为corePoolSize,继续提交的任务被保存到阻塞队列中,等待被执行; 如果执行了线程池的prestartAllCoreThreads()方法,线程池会提前创建并启动所有核心线程。 -

maximumPoolSize:线程池中允许的最大线程数。如果当前阻塞队列满了,且继续提交任务,则创建新的线程执行任务,前提是当前线程数小于maximumPoolSize -

keepAliveTime:线程空闲时的存活时间,即当线程没有任务执行时,继续存活的时间。默认情况下,该参数只在线程数大于corePoolSize时才有用 -

workQueue:必须是BlockingQueue阻塞队列。当线程池中的线程数超过它的corePoolSize的时候,线程会进入阻塞队列进行阻塞等待。通过workQueue,线程池实现了阻塞功能

-

RejectedExecutionHandler(饱和策略): 线程池的饱和策略,当阻塞队列满了,且没有空闲的工作线程,如果继续提交任务,必须采取一种策略处理该任务,线程池提供了5种策略:- (1)AbortPolicy:直接抛出异常,默认策略;

- (2)CallerRunsPolicy:用调用者所在的线程来执行任务;

- (3)DiscardOldestPolicy:丢弃阻塞队列中靠最前的任务,并执行当前任务;

- (4)DiscardPolicy:直接丢弃任务;

- (5)实现RejectedExecutionHandler接口,自定义饱和策略

-

allowCoreThreadTimeOut(核心线程是否销毁):该参数不在构造函数中,默认是false;如果设置为true,核心线程依然会被回收。

几种排allowCoreThreadTimeOut队的策略:

-

不排队,直接提交 将任务直接交给线程处理而不保持它们,可使用SynchronousQueue 如果不存在可用于立即运行任务的线程(即线程池中的线程都在工作),则试图把任务加入缓冲队列将会失败,因此会构造一个新的线程来处理新添加的任务,并将其加入到线程池中(corePoolSize-->maximumPoolSize扩容) Executors.newCachedThreadPool()采用的便是这种策略

-

无界队列 可以使用LinkedBlockingQueue(基于链表的有界队列,FIFO),理论上是该队列可以对无限多的任务排队,将导致在所有corePoolSize线程都工作的情况下将新任务加入到队列中。这样,创建的线程就不会超过corePoolSize,也因此,maximumPoolSize的值也就无效了

-

有界队列 可以使用ArrayBlockingQueue(基于数组结构的有界队列,FIFO),并指定队列的最大长度 使用有界队列可以防止资源耗尽,但也会造成超过队列大小和maximumPoolSize后,提交的任务被拒绝的问题,比较难调整和控制。

execute 和 submit接口的区别

- 接受参数,前者是Runnable接口,后者是Callable接口

- 返回值,前者没有返回值,后者返回Futrue对象

- 处理异常

线程池终止的方法

- shutdown, 当线程池调用该方法时,线程池的状态则立刻变成SHUTDOWN状态。此时,则不能再往线程池中添加任何任务,否则将会抛出RejectedExecutionException异常。但是,此时线程池不会立刻退出,直到添加到线程池中的任务都已经处理完成,才会退出。

- shutdownNow,执行该方法,线程池的状态立刻变成STOP状态,并试图停止所有正在执行的线程,不再处理还在池队列中等待的任务,当然,它会返回那些未执行的任务。 它试图终止线程的方法是通过调用Thread.interrupt()方法来实现的,如果线程中没有sleep 、wait、Condition、定时锁等应用, interrupt()方法是无法中断当前的线程的。所以,ShutdownNow()并不代表线程池就一定立即就能退出,它可能必须要等待所有正在执行的任务都执行完成了才能退出。

FixedThreadPool

固定线程池大小的,队列是无界的。构造函数如下:

public static ExecutorService newFixedThreadPool(int nThreads) {

return new ThreadPoolExecutor(nThreads, nThreads, 0L, TimeUnit.MILLISECONDS, new LinkedBlockingQueue<Runnable>());

}

FixedThreadPool的原理

- 如果当前运行的线程数少于corePoolSize,则创建新线程来执行任务。

- 在线程池完成预热之后(当前运行的线程数等于corePoolSize),将任务加入 LinkedBlockingQueue。

- 线程执行完1中的任务后,会在循环中反复从LinkedBlockingQueue获取任务来执行。

FixedThreadPool的特性

FixedThreadPool使用无界队列LinkedBlockingQueue作为线程池的工作队列(队列的容量为 Integer.MAX_VALUE)。使用无界队列作为工作队列会对线程池带来如下影响。

- 当线程池中的线程数达到corePoolSize后,新任务将在无界队列中等待,因此线程池中 的线程数不会超过corePoolSize。

- 由于1,使用无界队列时maximumPoolSize将是一个无效参数。

- 由于1和2,使用无界队列时keepAliveTime将是一个无效参数。

- 由于使用无界队列,运行中的FixedThreadPool(未执行方法shutdown()或 shutdownNow())不会拒绝任务(不会调用RejectedExecutionHandler.rejectedExecution方法)。

SingleThreadPool

public static ExecutorService newSingleThreadExecutor() {

return new FinalizableDelegatedExecutorService (new ThreadPoolExecutor(1, 1, 0L, TimeUnit.MILLISECONDS, new LinkedBlockingQueue<Runnable>()));

}

SingleThreadExecutor的corePoolSize和maximumPoolSize被设置为1。其他参数与 FixedThreadPool相同。SingleThreadExecutor使用无界队列LinkedBlockingQueue作为线程池的工 作队列(队列的容量为Integer.MAX_VALUE)。SingleThreadExecutor使用无界队列作为工作队列 对线程池带来的影响与FixedThreadPool相同,

SingleThreadPool工作流程

- 如果当前运行的线程数少于corePoolSize(即线程池中无运行的线程),则创建一个新线 程来执行任务。

- 在线程池完成预热之后(当前线程池中有一个运行的线程),将任务加入LinkedBlockingQueue。

- 线程执行完1中的任务后,会在一个无限循环中反复从LinkedBlockingQueue获取任务来 执行。

CachedThreadPool

public static ExecutorService newCachedThreadPool() {

return new ThreadPoolExecutor(0, Integer.MAX_VALUE, 60L, TimeUnit.SECONDS, new SynchronousQueue<Runnable>());

}

CachedThreadPool的corePoolSize被设置为0,即corePool为空;maximumPoolSize被设置为 Integer.MAX_VALUE,即maximumPool是无界的。这里把keepAliveTime设置为60L,意味着 CachedThreadPool中的空闲线程等待新任务的最长时间为60秒,空闲线程超过60秒后将会被终止。

CachedThreadPool使用没有容量的SynchronousQueue作为线程池的工作队列,但 CachedThreadPool的maximumPool是无界的。这意味着,如果主线程提交任务的速度高于 maximumPool中线程处理任务的速度时,CachedThreadPool会不断创建新线程。极端情况下, CachedThreadPool会因为创建过多线程而耗尽CPU和内存资源

ScheduledThreadPool

执行定时任务的线程池

FutureTask

FutureTask除了实现Future接⼜外,还实现了Runnable接⼜。因此,FutureTask可以交给 Executor执⾏,也可以由调⽤线程直接执⾏(FutureTask.run())。根据FutureTask.run()⽅法被执 ⾏的时机,FutureTask可以处于下⾯3种状态。

- 未启动。FutureTask.run()⽅法还没有被执⾏之前,FutureTask处于未启动状态。当创建 ⼀个FutureTask,且没有执⾏FutureTask.run()⽅法之前,这个FutureTask处于未启动状态。

- 已启动。FutureTask.run()⽅法被执⾏的过程中,FutureTask处于已启动状态。

- 已完成。FutureTask.run()⽅法执⾏完后正常结束,或被取消 (FutureTask.cancel(…)),或执⾏FutureTask.run()⽅法时抛出异常⽽异常结束,FutureTask 处于已完成状态。

核心线程池能不能销毁

使用构造函数设置的线程池核心线程池是不会销毁的,因为构造器没有这个参数,

而ThreadPoolExecutor 有一个成员变量,如果设置位true,核心线程数也是可以销毁的

/**

* If false (default), core threads stay alive even when idle.

* If true, core threads use keepAliveTime to time out waiting

* for work.

*/

private volatile boolean allowCoreThreadTimeOut;

CountDownLatch

原理

一个线程调用countDown方法 happen-before 另外一个线程调用await方法。底层使用AQS队列来实现。

场景

假如有这样一个需求,当我们需要解析一个Excel里多个sheet的数据时,可以考虑使用多线程,每个线程解析一个sheet里的数据,等到所有的sheet都解析完之后,程序需要提示解析完成。在这个需求中,要实现主线程等待所有线程完成sheet的解析操作,最简单的做法是使用join,这里使用CountDownLatch。

public class CountDownLatchTest {

static CountDownLatch c = new CountDownLatch(2);

public static void main(String[] args) throws InterruptedException {

new Thread(new Runnable() {

@Override

public void run() {

System.out.println(1);

c.countDown();

}

}).start();

c.await();

System.out.println("3");

}

}

CyclicBarrier

CyclicBarrier 的字面意思是可循环使用(Cyclic)的屏障(Barrier)。它要做的事情是,让一组线程到达一个屏障(也可以叫同步点)时被阻塞,直到最后一个线程到达屏障时,屏障才会开门,所有被屏障拦截的线程才会继续干活。CyclicBarrier默认的构造方法是CyclicBarrier(int parties),其参数表示屏障拦截的线程数量,每个线程调用await方法告诉CyclicBarrier我已经到达了屏障,然后当前线程被阻塞

public class CyclicBarrierTest {

static CyclicBarrier c = new CyclicBarrier(2);

public static void main(String[] args) {

new Thread(new Runnable() {

@Override

public void run() {

try {

c.await();

} catch (Exception e) {

}

System.out.println(1);

}

}).start();

try {

c.await();

} catch (Exception e) {

}

System.out.println(2);

}

}

CyclicBarrier和CountDownLatch的区别

- CountDownLatch的计数器只能使用一次。而CyclicBarrier的计数器可以使用reset() 方法重置。所以 CyclicBarrier能处理更为复杂的业务场景,比如如果计算发生错误,可以重置计数器,并让线程们重新执行一次。

- CyclicBarrier还提供其他有用的方法,比如getNumberWaiting方法可以获得CyclicBarrier阻塞的线程数量。isBroken方法用来知道阻塞的线程是否被中断。比如以下代码执行完之后会返回true

Semaphore

Semaphore(信号量)是用来控制同时访问特定资源的线程数量,它通过协调各个线程,以保证合理的使用公共资源。

public class SemaphoreTest {

private static final int THREAD_COUNT = 30;

private static ExecutorService threadPool = Executors

.newFixedThreadPool(THREAD_COUNT);

private static Semaphore s = new Semaphore(10);

public static void main(String[] args) {

for (int i = 0; i < THREAD_COUNT; i++) {

threadPool.execute(new Runnable() {

@Override

public void run() {

try {

s.acquire();

System.out.println("save data");

s.release();

} catch (InterruptedException e) {

}

}

});

}

threadPool.shutdown();

}

}

Exchanger

Exchanger(交换者)是一个用于线程间协作的工具类。Exchanger用于进行线程间的数据交换。它提供一个同步点,在这个同步点两个线程可以交换彼此的数据。这两个线程通过exchange方法交换数据, 如果第一个线程先执行exchange方法,它会一直等待第二个线程也执行exchange,当两个线程都到达同步点时,这两个线程就可以交换数据,将本线程生产出来的数据传递给对方。

public class ExchangerTest {

private static final Exchanger<String> exgr = new Exchanger<String>();

private static ExecutorService threadPool = Executors.newFixedThreadPool(2);

public static void main(String[] args) {

threadPool.execute(new Runnable() {

@Override

public void run() {

try {

String A = "银行流水A";// A录入银行流水数据

exgr.exchange(A);

} catch (InterruptedException e) {

}

}

});

threadPool.execute(new Runnable() {

@Override

public void run() {

try {

String B = "银行流水B";// B录入银行流水数据

String A = exgr.exchange("B");

System.out.println("A和B数据是否一致:" + A.equals(B) + ",A录入的是:"

+ A + ",B录入是:" + B);

} catch (InterruptedException e) {

}

}

});

threadPool.shutdown();

}

}

java异步

java异步的发展

jdk1.5 之前

- 缺少线程管理的原生支持

- 缺少锁的支持

- 缺少执行完成的支持

- 执行结果获取困难 thread/runnable

java1.5 juc框架横空出世

Executor

jdk1.7 Fork/join Forkjoinpool forkjoinTask recursiveAction

无法手动完成 阻塞式返回结果 无法处理多个future 无法合并多个future 缺少异常处理

jdk1.8 异步Fork/join

jdk1.9

guava异步实现

thrift异步实现

java 线程的使用。定时更新,

java并发中锁的使用

锁的原理

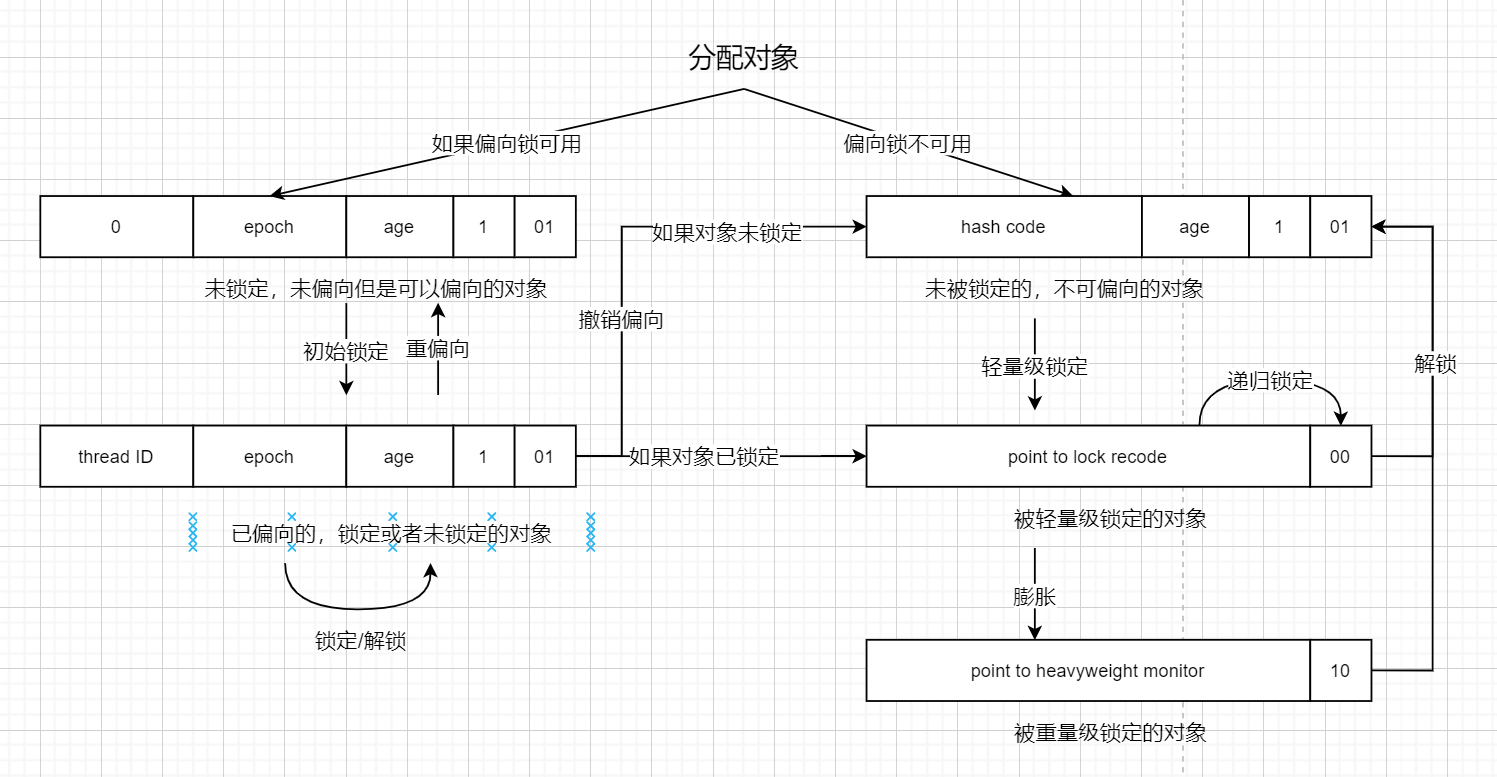

锁存在每个class对象上,位于对象头信息,也叫markword。只是相当与一个变量标识,标记一个对象是否已经加锁,或者释放锁。

final

一个变量是final所修饰,那么在所有线程中看到的该变量是一致的。不可变意味着线程安全。

volatile

java编程语言允许线程访问共享变量,为了确保共享变量能被准确和一致的更新,线程应该确保通过排他锁单独获得这个变量。

- 优点:读性能接近于普通读操作,写性能也非常高。

- 缺点:必须是原子操作,而且只能是一个变量。

synchronized和lock

synchronized是jvm底层实现,而lock是java api级别的实现,底层依赖于CAS操作。 一般来说,lock的性能高于synchronized,在jdk1.6以后,synchronized性能有很大改善。两者性能已经很接近。

happen-before原则

定义:如果操作a happens-before 操作b,那么b操作必须知道a的操作,或者说a的操作一定会通知到b,而不是a一定发生在b前。

1、程序次序规则(Program Order Rule)

在一个线程内,按照程序代码顺序,书写在前面的操作先行 发生于书写在后面的操作。准确地说,应该是控制流顺序而不是程序代码顺序,因为要考虑分支、循环 等结构。

2、管程锁定规则(Monitor Lock Rule)

一个unlock操作先行发生于后面对同一个锁的lock操作。这里 必须强调的是同一个锁,而“后面”是指时间上的先后顺序。

3、volatile变量规则(Volatile Variable Rule)

对一个volatile变量的写操作先行发生于后面对这个变量的 读操作,这里的“后面”同样是指时间上的先后顺序。

4、线程启动规则(Thread Start Rule)

Thread对象的start()方法先行发生于此线程的每一个动作。

5、线程终止规则(Thread Termination Rule)

线程中的所有操作都先行发生于对此线程的终止检测, 我们可以通过Thread.join()方法结束、Thread.isAlive()的返回值等手段检测到线程已经终止执行。

6、线程中断规则(Thread Interruption Rule)

对线程interrupt()方法的调用先行发生于被中断线程 的代码检测到中断事件的发生,可以通过Thread.interrupted()方法检测到是否有中断发生。

7、对象终结规则(Finalizer Rule)

一个对象的初始化完成(构造函数执行结束)先行发生于它的 finalize()方法的开始。

8、传递性(Transitivity)

如果操作A先行发生于操作B,操作B先行发生于操作C,那就可以得出操 作A先行发生于操作C的结论。

悲观锁和乐观锁

- 悲观锁(synchronized),定义:假设所有线程都会获得锁

- 读锁和读锁互斥,性能低

- 一个线程获得锁,其他线程只能等待

- 自动释放锁

- 乐观锁(ReentrantLock),定义:假设所有线程都不会锁住

- 读锁不互斥,性能高

- 实现非公平锁和公平锁,读写锁

- 手动控制释放锁

- 可以中断等待线程

公平锁和非公平锁

- 公平锁:按线程申请锁的时间顺序来进行。

- 非公平锁:不管线程申请锁的时间先后顺序,都是随机线程获得锁。

synchronized中的锁是非公平的,ReentrantLock默认情况下也是非公平的,但可以通过带布尔值的构造函数要求使用公平锁。

重入锁和不可重入锁

可重入和不可重入的概念是这样的:当一个线程获得了当前实例的锁,并进入方法A,这个线程在没有释放这把锁的时候,能否再次进入方法A呢?

- 可重入锁:可以再次进入方法A,就是说在释放锁前此线程可以再次进入方法A(方法A递归)。

- 不可重入锁(自旋锁):不可以再次进入方法A,也就是说获得锁进入方法A是此线程在释放锁钱唯一的一次进入方法A。

- 在java 中,synchronized和java.util.concurrent.locks.ReentrantLock是可重入锁

不可重入锁代码实现

public class Lock{

private volatile boolean isLocked = false;

public synchronized void lock()

throws InterruptedException{

while(isLocked){

wait();

}

isLocked = true;

}

public synchronized void unlock(){

isLocked = false;

notify();

}

}

可重入锁代码实现

public class Lock{

boolean isLocked = false;

Thread lockedBy = null;

int lockedCount = 0;

public synchronized void lock() throws InterruptedException{

Thread callingThread = Thread.currentThread();

while(isLocked && lockedBy != callingThread){

wait();

}

isLocked = true;

lockedCount++;

lockedBy = callingThread;

}

public synchronized void unlock(){

if(Thread.curentThread() == this.lockedBy){

lockedCount--;

if(lockedCount == 0){

isLocked = false;

notify();

}

}

}

}

参考《java并发编程的艺术》,《深入理解java虚拟机第二版》。

悲观锁定义

假设所有线程都会抢占同一资源,所以必须上锁。synchronized属于悲观锁的实现方式。

底层原理

在Java中,最基本的互斥同步手段就是synchronized关键字,synchronized关键字经过编译之后,会在同步块的前后分别形成monitorenter和monitorexit这两个字节码指令,这两个字节码都需要一个reference 类型的参数来指明要锁定和解锁的对象。如果Java程序中的synchronized明确指定了对象参数,那就是这 个对象的reference;如果没有明确指定,那就根据synchronized修饰的是实例方法还是类方法,去取对应 的对象实例或Class对象来作为锁对象

synchronized的作用域

synchronized是Java中的关键字,是一种同步互斥锁。它修饰的对象有以下几种:

- 修饰一个代码块,被修饰的代码块称为同步语句块,其作用的范围是大括号{}括起来的代码,作用的对象是调用这个代码块的对象;

- 修饰一个方法,被修饰的方法称为同步方法,其作用的范围是整个方法,作用的对象是调用这个方法的对象;

- 修改一个静态的方法,其作用的范围是整个静态方法,作用的对象是这个类的所有对象;

- 修改一个类,其作用的范围是synchronized后面括号括起来的部分,作用主的对象是这个类的所有对象

哪些场景使用

在临界资源竞争比较激烈的时候,使用synchronized反而更好。

cpu锁原理

关于CPU的锁有如下3种:

1、处理器自动保证基本内存操作的原子性

首先处理器会自动保证基本的内存操作的原子性。处理器保证从系统内存当中读取或者写入一个字节是原子的,意思是当一个处理器读取一个字节时,其他处理器不能访问这个字节的内存地址。奔腾6和最新的处理器能自动保证单处理器对同一个缓存行里进行16/32/64位的操作是原子的,但是复杂的内存操作处理器不能自动保证其原子性,比如跨总线宽度,跨多个缓存行,跨页表的访问。但是处理器提供总线锁定和缓存锁定两个机制来保证复杂内存操作的原子性。

2、使用总线锁保证原子性

第一个机制是通过总线锁保证原子性。如果多个处理器同时对共享变量进行读改写(i++就是经典的读改写操作)操作,那么共享变量就会被多个处理器同时进行操作,这样读改写操作就不是原子的,操作完之后共享变量的值会和期望的不一致,举个例子:如果i=1,我们进行两次i++操作,我们期望的结果是3,但是有可能结果是2。如下图

原因是有可能多个处理器同时从各自的缓存中读取变量i,分别进行加一操作,然后分别写入系统内存当中。那么想要保证读改写共享变量的操作是原子的,就必须保证CPU1读改写共享变量的时候,CPU2不能操作缓存了该共享变量内存地址的缓存。 处理器使用总线锁就是来解决这个问题的。所谓总线锁就是使用处理器提供的一个LOCK#信号,当一个处理器在总线上输出此信号时,其他处理器的请求将被阻塞住,那么该处理器可以独占使用共享内存。

3、使用缓存锁保证原子性

第二个机制是通过缓存锁定保证原子性。在同一时刻我们只需保证对某个内存地址的操作是原子性即可,但总线锁定把CPU和内存之间通信锁住了,这使得锁定期间,其他处理器不能操作其他内存地址的数据,所以总线锁定的开销比较大,最近的处理器在某些场合下使用缓存锁定代替总线锁定来进行优化。